Construindo em Sussurrarpesquisadores de Oxford estão desenvolvendo o WhisperX para timestamp eficaz em nível de palavra em transcrições de fala de formato longo.

Devido à disponibilidade de extensos conjuntos de dados on-line, abordagens de treinamento fracamente supervisionadas e não supervisionadas demonstraram excelente desempenho em uma variedade de tarefas de processamento de áudio, incluindo voz reconhecimento, palestrante reconhecimento, discurso separaçãoe palavra-chave manchar.

Como o Whisper e o WhisperX funcionam?

Whisper, um sistema de reconhecimento de fala criado por pesquisadores de Oxford, faz uso dessas informações substanciais em maior escala. Eles mostram como o pré-treinamento fracamente supervisionado de um transformador de codificador-decodificador básico pode alcançar a transcrição de fala multilíngue de disparo zero em benchmarks reconhecidos usando 125.000 horas de dados de tradução em inglês e 680.000 horas de dados de treinamento de fala ruidosa em 96 idiomas adicionais.

Embora a maioria dos benchmarks acadêmicos consista em breves declarações, em contextos do mundo real, como reuniões, podcasts e vídeos, frequentemente é necessária a transcrição de áudios longos que podem durar horas ou minutos.

Projetos de transformadores empregados em reconhecimento de fala automatizado (ASR) não permitem a transcrição de áudio de entrada arbitrariamente longo (até 30 segundos no caso de Whisper) devido a restrições de memória.

Pesquisas recentes empregam métodos heurísticos de janela deslizante, que são propensos a erros devido a áudio incompleto, onde algumas palavras podem ser perdidas ou transcritas incorretamente se estiverem no início ou no final do segmento de entrada; e áudio sobrepostoo que pode resultar em transcrições inconsistentes quando o modelo processa a mesma fala duas vezes.

Whisper apresenta uma técnica de transcrição tamponada que determina até que ponto a janela de entrada deve ser deslocada baseado em previsão precisa de carimbo de data/hora. Esse método é suscetível a graves desvios porque as imprecisões do carimbo de data/hora em uma janela podem resultar em problemas nas janelas subsequentes.

Eles usam uma série de heurísticas caseiras para tentar erradicar esses erros, embora frequentemente não tenham sucesso em fazê-lo. A decodificação vinculada do Whisper, que faz uso de um único codificador-decodificador para decodificar timestamps e transcrições, é propenso aos problemas usuais com geração de linguagem auto-regressivanotavelmente alucinação e repetição.

Atividades de formato longo e outras atividades sensíveis ao carimbo de data/hora, como diarização do alto-falante, leitura labiale aprendizagem audiovisual são adversamente afetados por isso, bem como a transcrição tamponada.

O papel do sussurro afirma que uma parte considerável do corpus de treinamento consiste em dados incompletos (pares de transcrição de áudio sem informações de timestamp), denotados pelo token |nottimestamps|>. O desempenho da transcrição da fala é involuntariamente sacrificado para carimbo de data/hora menos preciso previsão ao escalar em material de transcrição imperfeito e ruidoso.

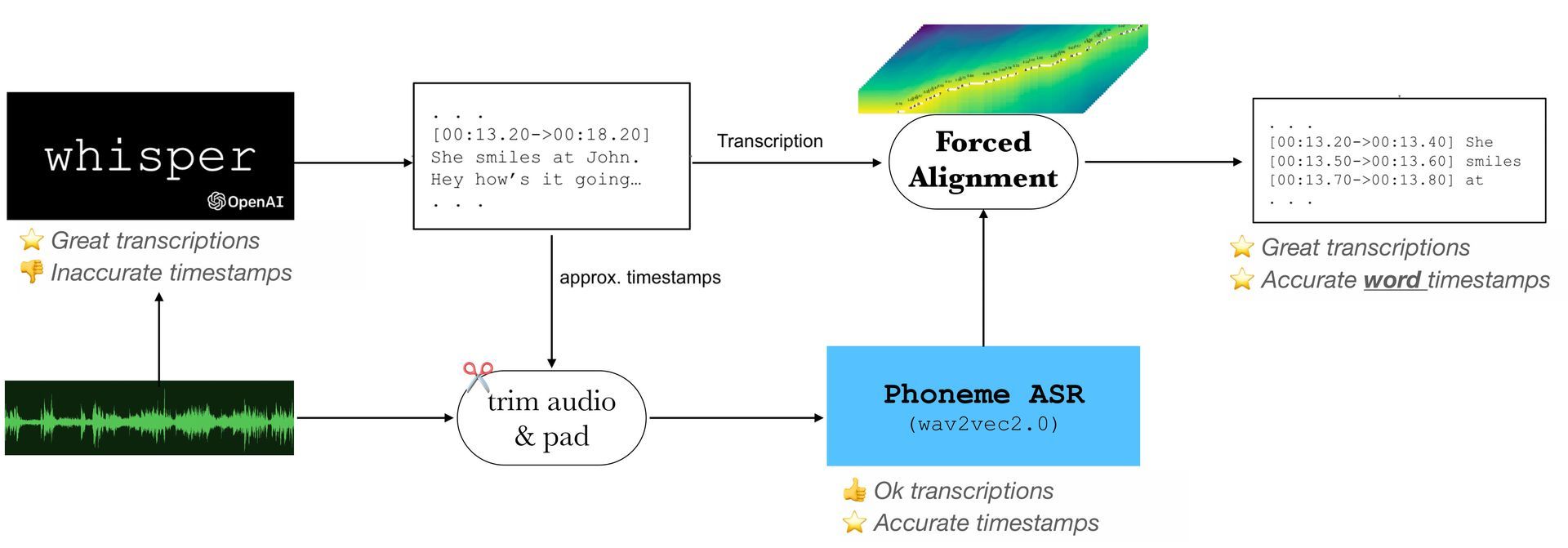

Como resultado, ao usar módulos adicionais, a fala e a transcrição devem se alinhar adequadamente. Em “alinhamento forçado“, a transcrição da fala e as formas de onda de áudio são sincronizadas no nível da palavra ou do fonema. O Modelo oculto de Markov (HMM) e o subproduto de possíveis alinhamentos de estado são freqüentemente usados no treinamento dos modelos de fones acústicos.

Modelos de correção de limite externo são freqüentemente usados para corrigir os timestamps para essas palavras ou números de telefone. Devido à rápida expansão metodologias baseadas em aprendizado profundoalguns estudos recentes usam técnicas de aprendizado profundo para alinhamento forçado, como a aplicação de uma matriz de atenção bidirecional ou segmentação CTC com o modelo treinado de ponta a ponta.

Melhorias adicionais podem ser alcançadas combinando um modelo ASR de última geração com um modelo de reconhecimento de fonema direto, ambos construídos usando conjuntos de dados significativos em grande escala.

Quando WhisperX entra em cena

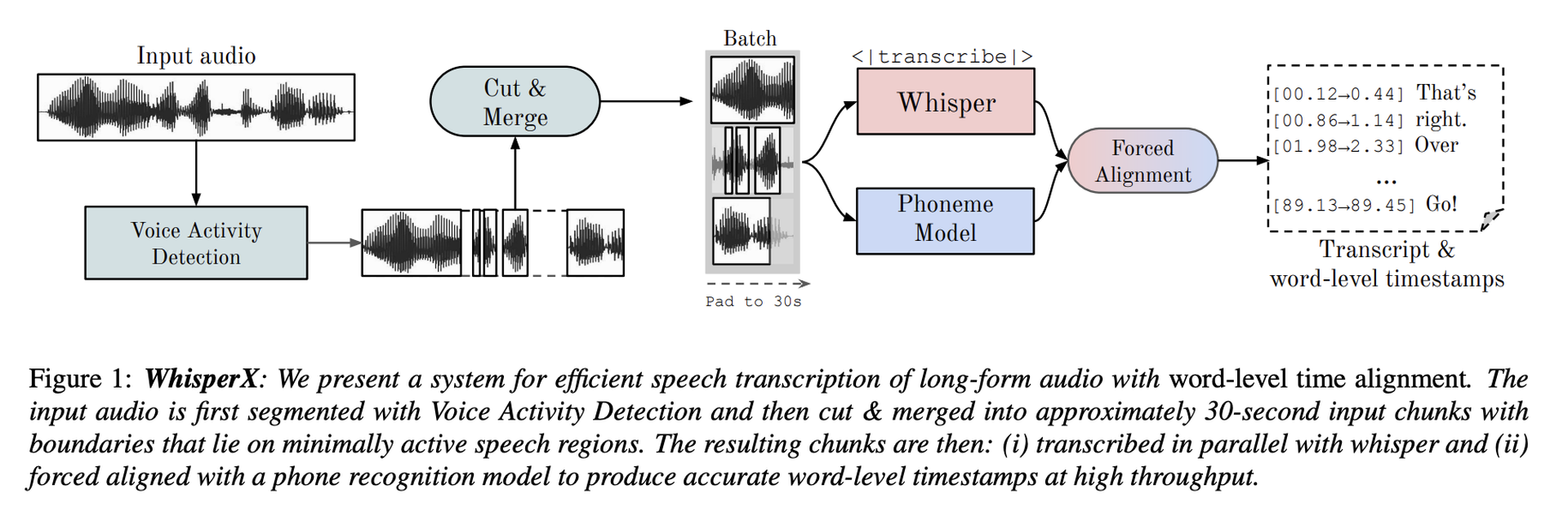

eles propõem WhisperX, uma técnica para transcrição precisa de fala de gravações longas com carimbos de data/hora precisos em nível de palavra, como uma solução para esses problemas. Além de transcrição sussurradatambém compreende as três etapas a seguir:

- Usando um modelo externo de detecção de atividade de voz (VAD) para pré-segmentar o áudio de entrada.

- Os segmentos VAD resultantes são divididos e mesclados em blocos de entrada de aproximadamente 30 segundos com limites nas regiões de fala com a menor quantidade de atividade.

- Para fornecer carimbos de data/hora precisos em nível de palavra, eles exigem alinhamento com um modelo de fonema externo.

Com o surgimento da IA e dos chatbots de IA baseados em texto, os programas de conversão de texto em fala e de reconhecimento de fala estão em alta demanda. Apenas esta semana, o aplicativo de bate-papo por vídeo ChatGPT, Call Annie AI, foi lançado em uma tentativa de capitalizar essa demanda crescente. Embora o futuro de WhisperX ainda não esteja totalmente claro sobre suas possibilidades, podemos dizer que definitivamente vale a pena acompanhar seu progresso.

Source: Whisper e WhisperX: sistema de transcrição de fala com precisão de tempo de pesquisadores de Oxford