O Meta Llama 3.1 405B foi oficialmente anunciado, fazendo seu nome antes mesmo de suas capacidades de IA serem lançadas. Desenvolvido pela Meta, este modelo de ponta oferece flexibilidade, controle e desempenho sem precedentes para rivalizar com os melhores modelos de IA de código fechado.

Ontem, alguns usuários tiveram uma prévia do seu potencial e hoje temos testes de benchmark oficiais destacando suas capacidades impressionantes. Você também pode ler mais sobre as revelações de ontem aqui.

O que é Meta Llama 3.1 405B?

Hoje aqui aprenderemos tudo o que há para saber sobre o Meta Llama 3.1 405B. O Llama 3.1 405B é uma IA de código aberto que se destaca em uma variedade de tarefas, como conhecimento geral, navegabilidade, matemática, uso de ferramentas e tradução multilíngue, enquanto as versões de nível médio 70B e nível mínimo 8B também se destacam em suas respectivas classes. Com um comprimento de contexto de 128K e suporte para oito idiomas, este modelo foi projetado para lidar com aplicativos complexos e diversos.

Treinado em mais de 15 trilhões de tokens usando mais de 16 mil GPUs H100, o Llama 3.1 405B se destaca como um dos modelos de IA mais poderosos e capazes disponíveis. Muita energia foi investida nessa IA. Agora podemos começar a ficar técnicos.

Principais recursos do Meta Llama 3.1 405B

Meta Lhama 3.1 405B oferece vários recursos avançados:

- Comprimento de contexto estendido: Suporta até 128K de comprimento de contexto, ideal para resumos de texto longos e conversas complexas.

- Capacidades multilíngues: Suporta vários idiomas, o que o torna versátil para aplicações globais.

- Uso avançado de ferramentas: Capaz de integração com diversas ferramentas para funcionalidade aprimorada.

- Geração de dados sintéticos: Facilita a criação de dados sintéticos para melhorar e treinar modelos menores.

- Destilação modelo: Permite a destilação de modelos grandes em versões menores e mais eficientes.

A Meta fez parceria com mais de 25 empresas para tornar Meta Lhama 3.1 405B mais fácil de usar. Esse suporte de ecossistema torna mais viável para desenvolvedores e pesquisadores trabalharem com esse modelo poderoso, mesmo sem acesso a recursos computacionais massivos.

Como usar o Meta Llama 3.1 405B

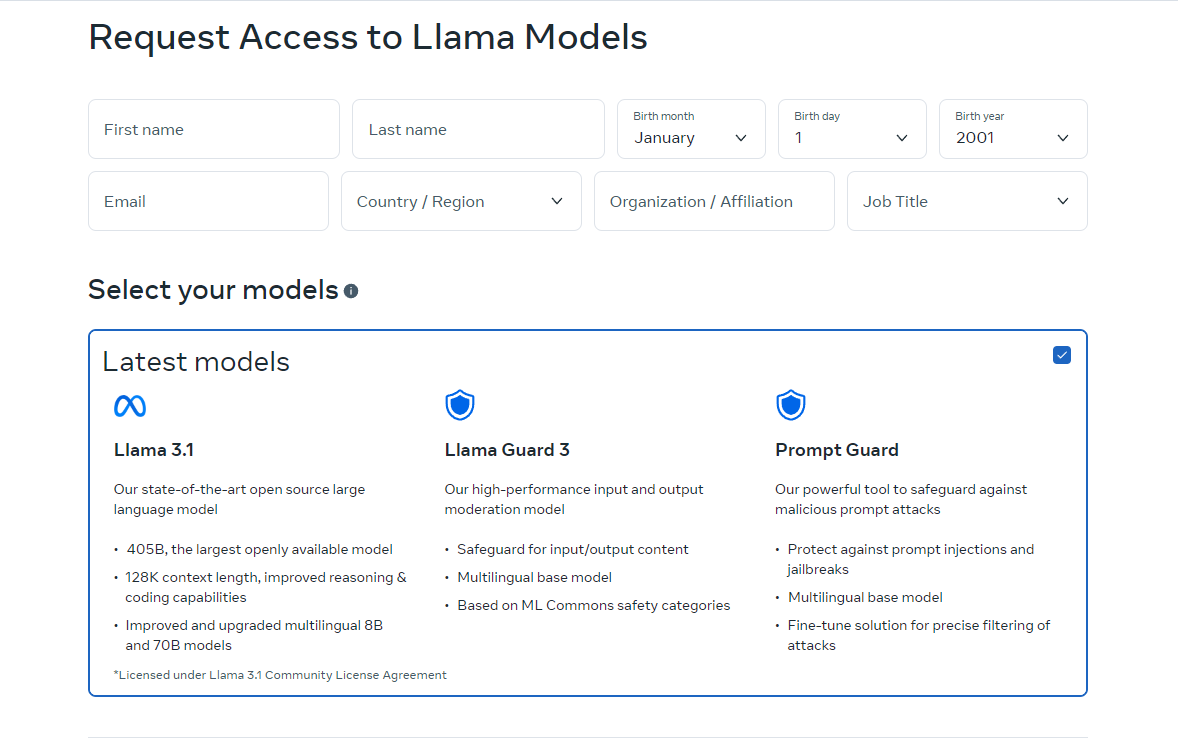

Para começar a usar o Meta Llama 3.1 405B, siga estes passos:

- Acesse o modelo: Visita llama.meta.com ou Abraçando o Rosto para download o modelo. Essas plataformas fornecem os arquivos e a documentação necessários para começar.

- Configure seu ambiente: Garanta que você tenha um ambiente adequado para executar o modelo. Isso inclui ter o hardware necessário, como GPUs, e dependências de software como Python e PyTorch.

- Carregar o modelo: Use os snippets de código e diretrizes fornecidos para carregar o modelo em seu aplicativo. O Meta fornece instruções detalhadas para ajudar você a integrar o Llama 3.1 405B em seus projetos.

- Executar inferência: Comece a usar o modelo para inferência em tempo real ou em lote. Você pode fazer perguntas ao modelo, gerar texto ou executar traduções usando seus recursos poderosos.

- Ajuste fino para tarefas específicas: Se necessário, você pode ajustar o modelo para aplicações específicas usando técnicas de ajuste fino supervisionadas. O Meta oferece recursos e exemplos para guiá-lo por esse processo.

A versão online do Llama está disponível atualmente apenas em certos países. No entanto, você também pode usá-lo localmente baixando os códigos de código aberto. As instruções de download estão disponíveis nos sites para os quais o direcionamos. Você também pode usar o Meta Llama 3.1 405B via Grog.

Como usar o Meta Llama 3.1 405B no Groq

Meta Llama 3.1 405B, o maior e mais capaz modelo de fundação aberta até o momento, agora está disponível na Groq. Este guia o orientará a começar a usar o Meta Llama 3.1 405B na Groq.

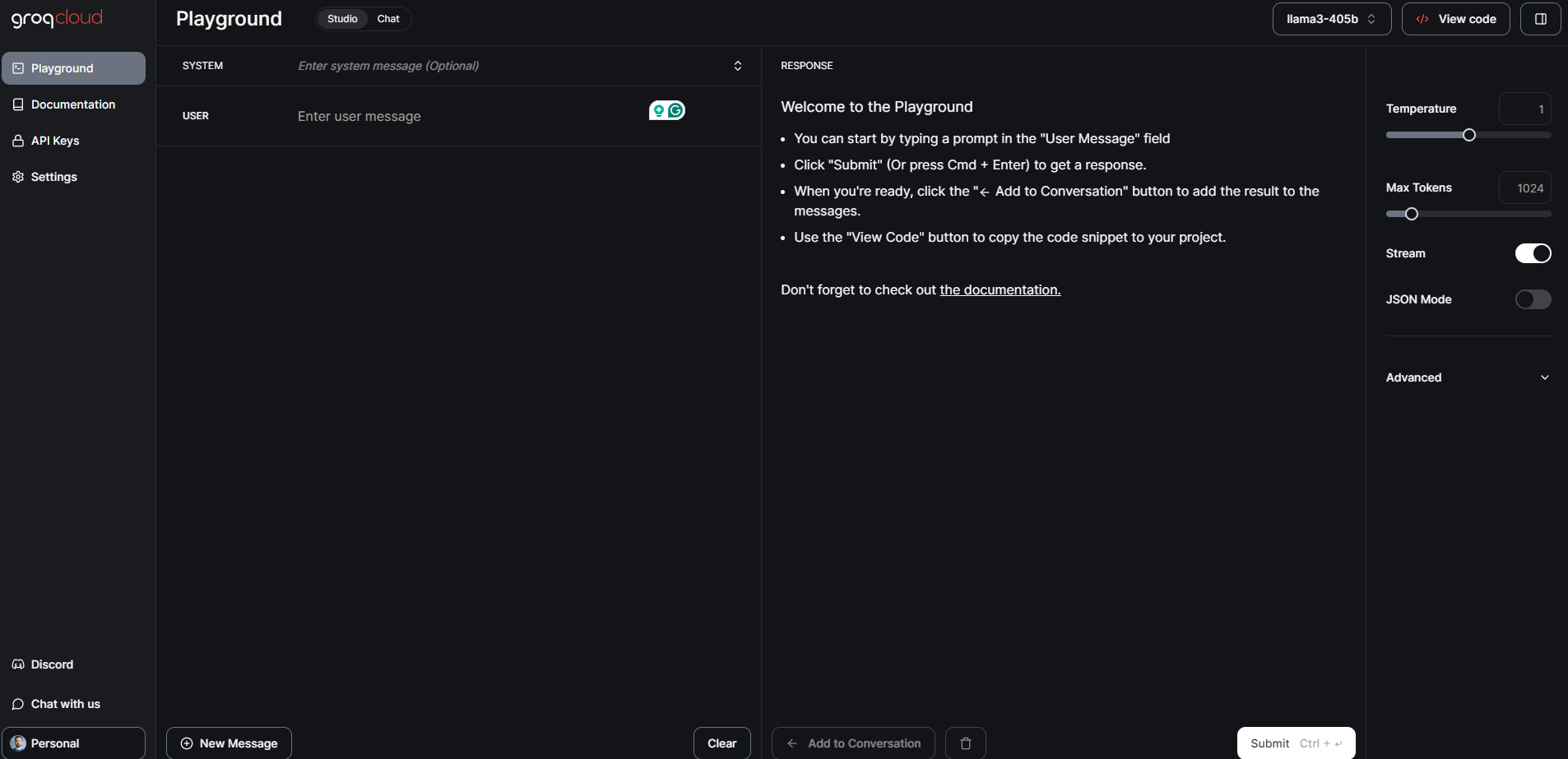

Etapa 1: Console de desenvolvimento GroqCloud

- Inscreva-se/Entre: Visite a Console de desenvolvimento GroqCloud e inscreva-se ou faça login na sua conta.

- Encontre modelos Meta Llama 3.1: Navegue até a seção de modelos e procure por Meta Llama 3.1 405B. Você também encontrará os modelos 70B e 8B Instruct disponíveis.

- Obtenha uma chave de API: Obtenha uma chave de API Groq gratuita no console. Essa chave permitirá que você interaja com o modelo.

GroqChat

Para acesso público em geral, você pode usar o GroqChat:

- Visite GroqChat: Vá para GroqChat para interagir diretamente com Meta Llama 3.1 405B.

- Explorar recursos: Teste os recursos do modelo em tempo real, como gerar texto, traduções ou responder a consultas.

Etapa 2: Configurando seu ambiente

Requisitos de hardware e software

- Hardware: Certifique-se de ter hardware adequado, de preferência GPUs, para lidar com os requisitos do modelo.

- Programas: Instale as dependências de software necessárias, como Python e PyTorch. Você pode encontrar instruções detalhadas de configuração no GroqCloud Dev Console.

Configuração do ambiente

- Integração de API: Substitua sua chave de API padrão do setor existente pela chave de API do Groq.

- Definir URL base: Configure seu aplicativo para usar a URL base do Groq para solicitações de API.

Etapa 3: Carregando e executando o modelo

Carregando o modelo

- Partes de codigo: Use os trechos de código fornecidos no GroqCloud Dev Console para carregar o Meta Llama 3.1 405B em seu aplicativo.

- Inicialização: Inicialize o modelo com a chave de API e configure todos os parâmetros necessários para seu caso de uso específico.

Inferência em execução

- Inferência em tempo real: Comece a executar inferências em tempo real enviando consultas ao modelo e recebendo respostas.

- Processamento em lote: Para tarefas maiores, você pode usar o processamento em lote para lidar com várias consultas simultaneamente.

Etapa 4: Ajuste fino para tarefas específicas

- Dados de treinamento: Prepare seu conjunto de dados para a aplicação específica para a qual você deseja ajustar o modelo.

- Processo de ajuste fino: Siga as instruções detalhadas fornecidas pela Meta e Groq para ajustar o modelo usando técnicas supervisionadas.

- Validação: Valide o modelo ajustado para garantir que ele atenda aos critérios de desempenho desejados.

Meta Llama 3.1 405B: Testes de benchmark e desempenho

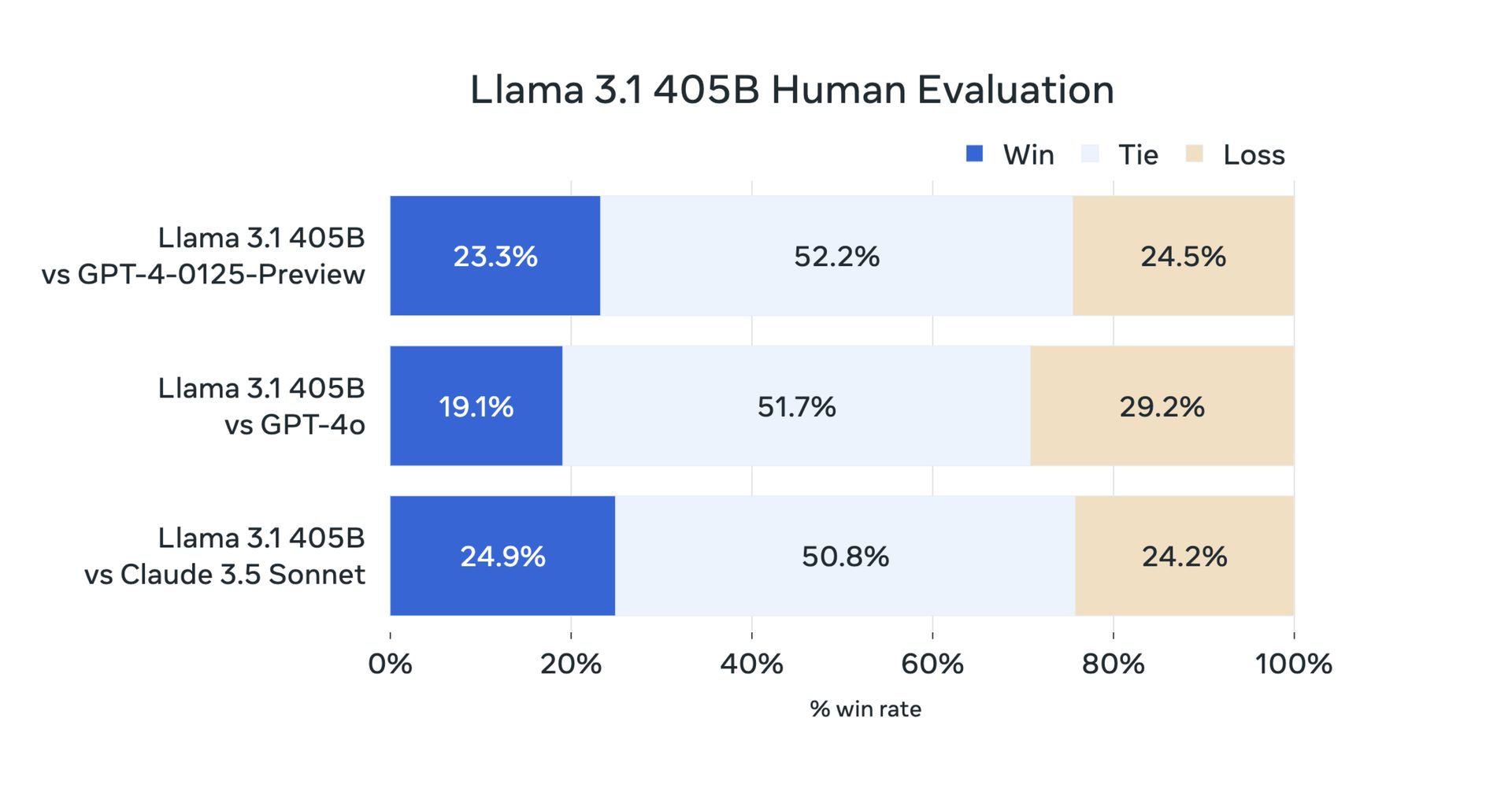

Ontem, devido à sua natureza de código aberto, os usuários fizeram seus testes. Mas agora os testes de benchmark oficiais confirmaram que o Meta Llama 3.1 405B tem um desempenho excepcionalmente bom em uma variedade de tarefas. O modelo foi avaliado em mais de 150 conjuntos de dados de benchmark e comparado a modelos líderes como GPT-4 e Claude 3.5 Sonnet. Os resultados mostram que o Llama 3.1 405B é competitivo com esses modelos principais e oferece desempenho de alta qualidade em cenários do mundo real.

Primeiro, aqui estão os benchmarks Llama 3.1 8B e Llama 3.1 70B:

| Categoria | Referência | Lhama 3.1 8B | Gemma 2 9B TI | Mistral 7B Instrutor | Lhama 3.1 70B | Mixtral 8x22B Instruir | GPT 3.5 Turbo |

|---|---|---|---|---|---|---|---|

| Em geral | MMLU (0-tiro, CoT) | 73,0 | 72,3 | 60,5 | 86,0 | 79,9 | 69,8 |

| Em geral | MMLU PRO (5 tiros, CoT) | 48,3 | – | 36,9 | 66,4 | 56,3 | 49,2 |

| Em geral | IFEval | 80,4 | 73,6 | 57,6 | 87,5 | 72,7 | 69,9 |

| Código | HumanEval (0-tiro) | 72,6 | 54,3 | 40.2 | 80,5 | 75,6 | 68,0 |

| Código | MBPP EvalPlus (base) (0-tiro) | 72,8 | 71,7 | 49,5 | 86,0 | 78,6 | 82,0 |

| Matemática | GSM8K (8 disparos, CoT) | 84,5 | 76,7 | 53,2 | 95,1 | 88,2 | 81,6 |

| Matemática | MATEMÁTICA (0-tiro, CoT) | 51,9 | 44,3 | 13.0 | 68,0 | 54.1 | 43.1 |

| Raciocínio | Desafio ARC (0-tiro) | 83,4 | 87,6 | 74,2 | 94,8 | 88,7 | 83,7 |

| Raciocínio | GPQA (0-tiro, CoT) | 32,8 | – | 28,8 | 46,7 | 33,3 | 30,8 |

| Uso de ferramentas | BFCL | 76,1 | – | 60,4 | 84,8 | – | 85,9 |

| Uso de ferramentas | Nexo | 38,5 | 30,0 | 24,7 | 56,7 | 48,5 | 37.2 |

| Contexto longo | ZeroSCROLLS/Qualidade | 81,0 | – | – | 90,5 | – | – |

| Contexto longo | InfiniteBench/En.MC | 65,1 | – | – | 78,2 | – | – |

| Contexto longo | NIH/Multi-agulha | 98,8 | – | – | 97,5 | – | – |

| Multilíngue | MGSM multilíngue (0-shot) | 68,9 | 53,2 | 29,9 | 86,9 | 71,1 | 51,4 |

E há um benchmark Meta Llama 3.1 405B:

| Categoria | Referência | Lhama 3.1 405B | Nemotron 4 340B Instruir | GPT-4 (0125) | GPT-4 Omni | Soneto Claude 3.5 |

|---|---|---|---|---|---|---|

| Em geral | MMLU (0-tiro, CoT) | 88,6 | 78,7 (não CoT) | 85,4 | 88,7 | 88,3 |

| Em geral | MMLU PRO (5 tiros, CoT) | 73,3 | 62,7 | 64,8 | 74,0 | 77,0 |

| Em geral | IFEval | 88,6 | 85,1 | 84,3 | 85,6 | 88,0 |

| Código | HumanEval (0-tiro) | 89,0 | 73,2 | 86,6 | 90,2 | 92,0 |

| Código | MBPP EvalPlus (base) (0-tiro) | 88,6 | 72,8 | 83,6 | 87,8 | 90,5 |

| Matemática | GSM8K (8 disparos, CoT) | 96,8 | 92,3 (0-tiro) | 94,2 | 96,1 | 96,4 (0-tiro) |

| Matemática | MATEMÁTICA (0-tiro, CoT) | 73,8 | 41.1 | 64,5 | 76,6 | 71,1 |

| Raciocínio | Desafio ARC (0-tiro) | 96,9 | 94,6 | 96,4 | 96,7 | 96,7 |

| Raciocínio | GPQA (0-tiro, CoT) | 51.1 | – | 41,4 | 53,6 | 59,4 |

| Uso de ferramentas | BFCL | 88,5 | 86,5 | 88,3 | 80,5 | 90,2 |

| Uso de ferramentas | Nexo | 58,7 | – | 50,3 | 56.1 | 45,7 |

| Contexto longo | ZeroSCROLLS/Qualidade | 95,2 | – | – | 90,5 | 90,5 |

| Contexto longo | InfiniteBench/En.MC | 83,4 | – | 72,1 | 82,5 | – |

| Contexto longo | NIH/Multi-agulha | 98,1 | – | 100,0 | 100,0 | 90,8 |

| Multilíngue | MGSM multilíngue (0-shot) | 91,6 | – | 85,9 | 90,5 | 91,6 |

O Meta Llama 3.1 405B representa o progresso na IA de código aberto ao fornecer aos desenvolvedores e pesquisadores uma ferramenta poderosa para uma variedade de aplicações. Com seus recursos avançados, ecossistema robusto e comprometimento com o desenvolvimento responsável, esperamos que o Llama 3.1 405B traga inovações para as comunidades de IA 70B e 8B. Aqui está tudo o que preparamos para você.

Crédito da imagem em destaque: Meta IA

Source: Tudo o que você precisa saber sobre o Meta Llama 3.1 405B