Os avanços na tecnologia continuam a remodelar o cenário da segurança cibernética, apresentando novas oportunidades e riscos imprevistos. Uma equipe de pesquisadores vindos de universidades britânicas demonstrou uma exploração alarmante que aproveita as ondas sonoras para furtar dados confidenciais das teclas digitadas. A técnica, que emprega um modelo de aprendizado profundo, possui uma impressionante taxa de precisão de 95%.

O experimento foi baseado no reconhecimento de que as ondas sonoras geradas pelo pressionamento do teclado podem ser aproveitadas para discernir os pressionamentos de tecla reais. Os pesquisadores embarcaram em uma jornada pioneira que mostrou os perigos potenciais de ataques acústicos à segurança de dados.

A metodologia da pesquisa

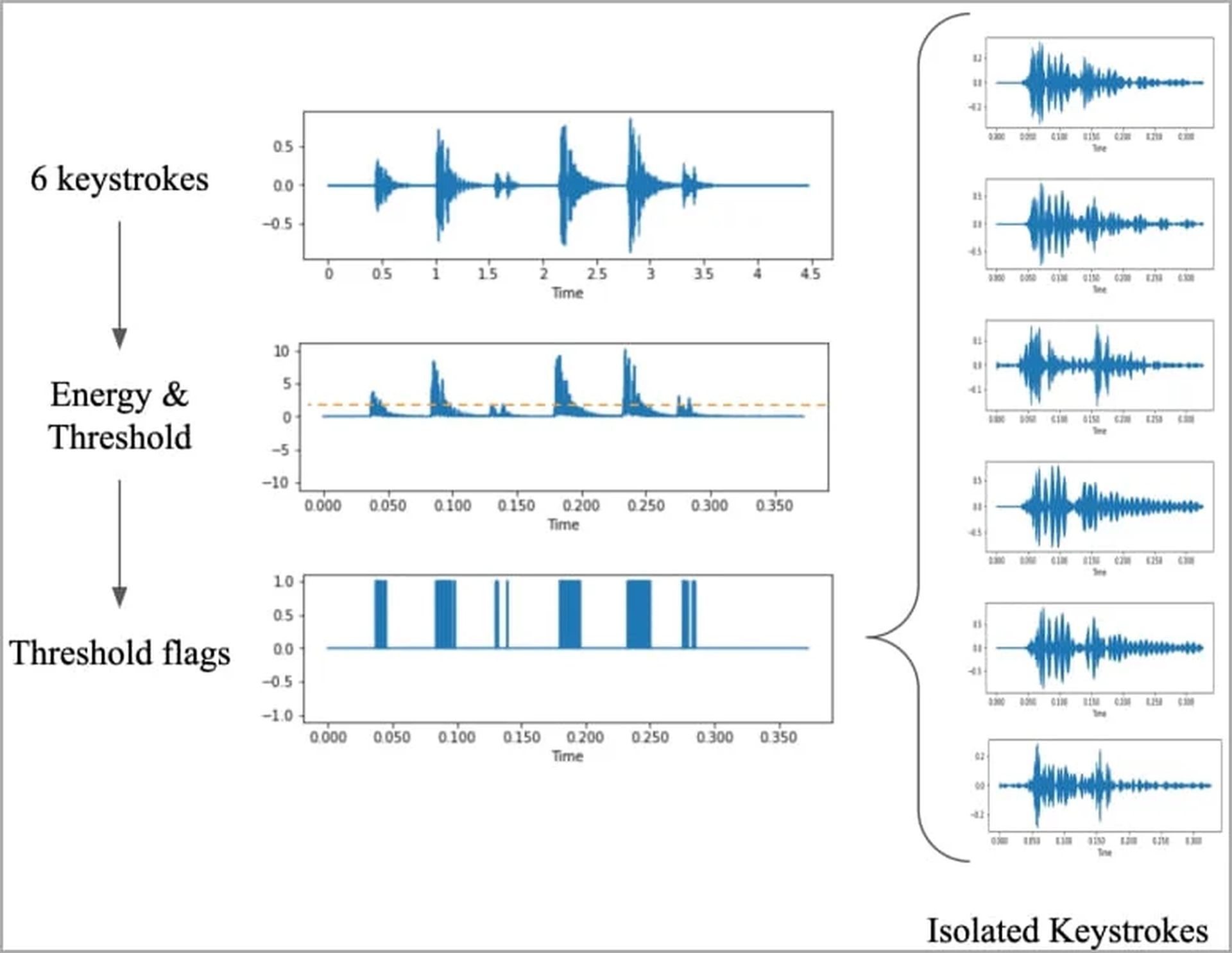

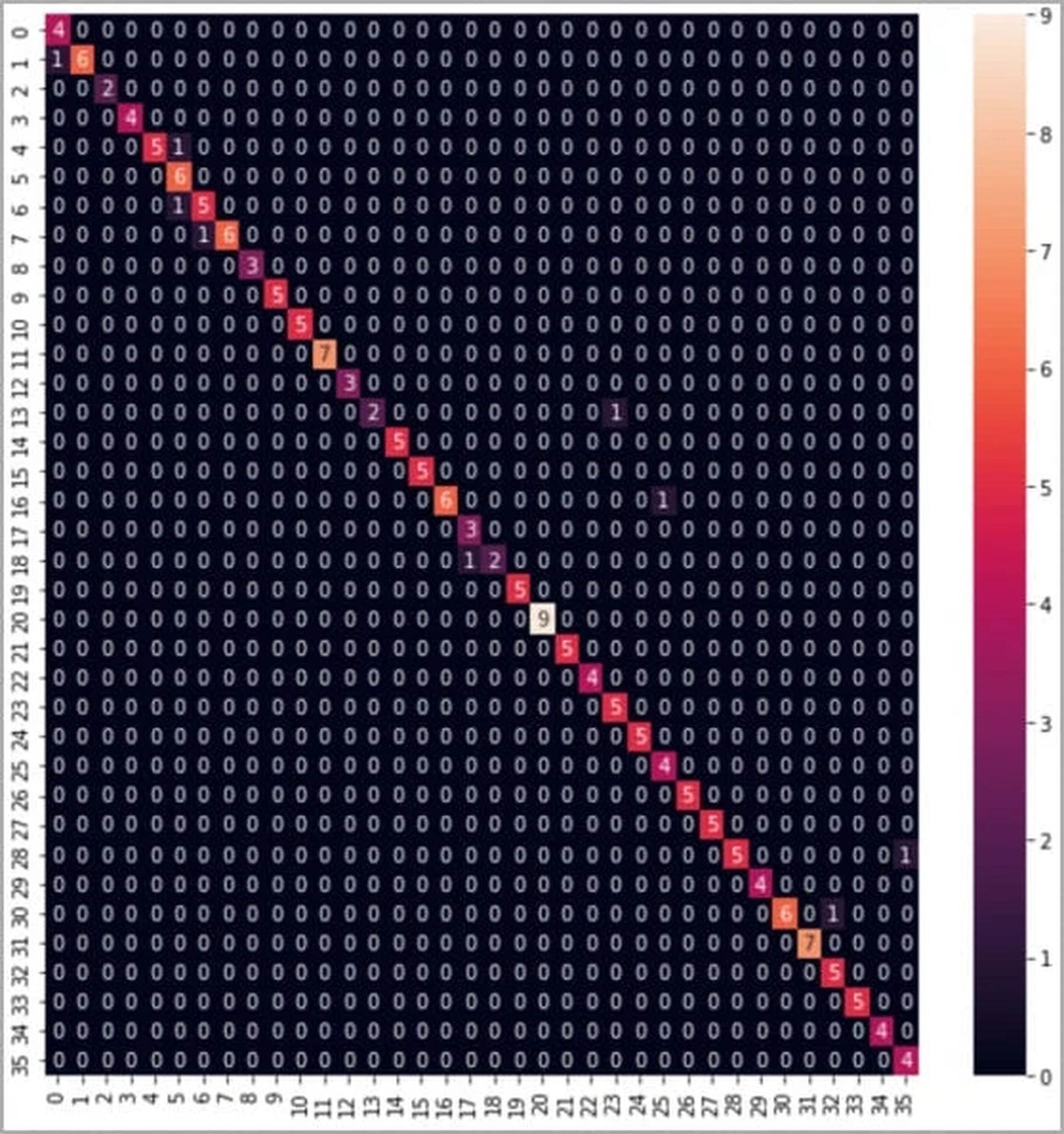

No centro desta façanha audaciosa está o intrincado interação entre som, aprendizado de máquina e extração de dados. A equipe de pesquisa empregou uma variedade de dispositivos, desde laptops para smartphones, para capturar os perfis sonoros exclusivos das teclas digitadas. Um total de 36 teclas foram pressionadas 25 vezes cada em um MacBook Pro moderno, enquanto os sinais de áudio resultantes foram meticulosamente gravados.

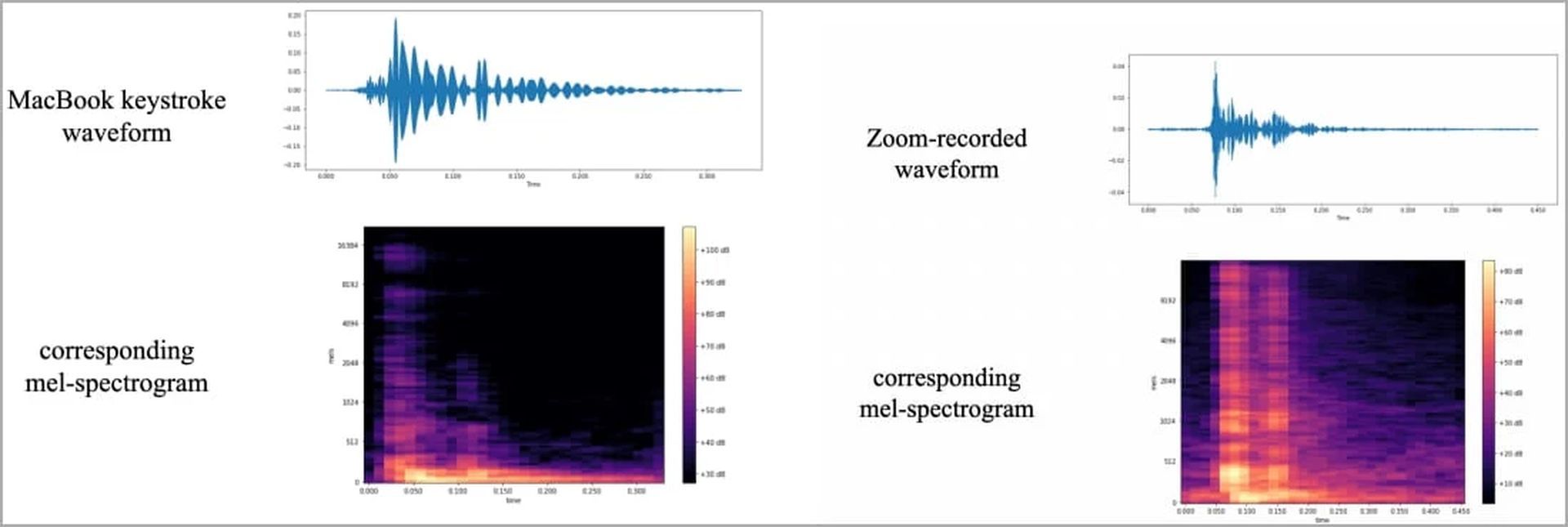

Os dados sonoros capturados foram submetidos uma série de etapas de processamento, eventualmente se transformando em representações visuais, como formas de onda e espectrogramas. Essas visualizações mostraram variações distintas para cada pressionamento de tecla, abrindo caminho para o desenvolvimento de um poderoso classificador de imagens, chamado ‘CoAtNet.’

As implicações dos resultados

As implicações desta pesquisa são profundo e inquietante. Ataques baseados em acústica contornar as medidas de segurança tradicionais, explorando o onipresença de dispositivos equipados com microfone para obter acesso não autorizado a informações confidenciais. Essa nova abordagem é particularmente preocupante, pois pode potencialmente expor dados pessoais, incluindo senhas, conversas, mensagens, e outros dados confidenciais a atores maliciosos.

Os ataques tradicionais de canal lateral geralmente exigem condições específicas e geralmente são limitados por taxa de dados e restrições de distância. No entanto, os ataques acústicos deram início a uma nova era de simplicidade e eficiência, aproveitando a abundância de dispositivos capazes de gravar áudio de alta qualidade.

Estratégias de mitigação

Como esta pesquisa inovadora ressalta a importância crítica da proteção contra ataques acústicos, torna-se essencial explorar as estratégias de mitigação que os usuários podem empregar para proteger seus dados.

- Estilos de digitação alterados: O estudo recomenda que os usuários considerem alterar seus estilos de digitação para ofuscar a assinatura acústica de suas teclas.

- Senhas aleatórias: O uso de senhas aleatórias pode interromper os recursos de reconhecimento de padrão de invasores baseados em acústica.

- Defesas baseadas em software: Empregar software que imita sons de teclas, gerando ruído branco ou utilizando filtros de áudio baseados em software pode impedir o roubo de dados.

- Autenticação biométrica: A implementação de métodos de autenticação biométrica pode aumentar a segurança adicionando uma camada adicional de verificação de identidade.

- Gerenciadores de senhas: Contar com gerenciadores de senhas pode minimizar a necessidade de entrada manual de informações confidenciais, reduzindo a exposição a ataques acústicos.

Em um mundo caracterizado pela rápida evolução da tecnologia, as preocupações com a segurança também continuam a evoluir. A pesquisa serve como um lembrete claro de que métodos inovadores de roubo de dados surgem constantemente, necessitando de uma abordagem proativa e adaptável à segurança cibernética. À medida que o mundo digital avança, nossas defesas também devem avançar contra aqueles que procuram explorar suas vulnerabilidades.

Além da pesquisa de universidades britânicas, houve desenvolvimentos crescentes de modelos de IA focados em roubo de dados e práticas de hacking. No mês passado, surgiu um modelo de IA focado em roubo de dados com o nome FraudGPT, bem como um modelo de IA chamado WormgGPT, que afirma não ter limites, permitindo conversas ilegais e antiéticas.

Se você deseja estar mais preparado em relação aos desenvolvimentos em andamento nos modelos de aprendizado profundo e IA, verifique nosso artigo sobre como tomar cuidado com os golpes generalizados do ChatGPT.

Crédito da imagem em destaque: Sergi Kabrera / Unsplash

Source: Pesquisadores desenvolvem modelo de aprendizado profundo que rouba dados de teclas digitadas