A OpenAI desenvolveu um novo modelo baseado em GPT-4, CriticGPT, que é um passo importante para avaliar o resultado produzido por sistemas avançados de IA. O modelo foi projetado para detectar erros no código ChatGPT.

A pesquisa mostrou que quando as pessoas examinam o código ChatGPT com a ajuda do CriticGPT, elas têm um desempenho 60% melhor do que aquelas sem ajuda. OpenAI visa fornecer suporte de inteligência artificial aos treinadores, integrando modelos semelhantes no processo de rotulagem “Aprendizagem por Reforço a partir de Feedback Humano” (RLHF). Então, o que é esse CriticGPT? Vamos olhar mais de perto.

O que é CriticGPT e o que ele faz?

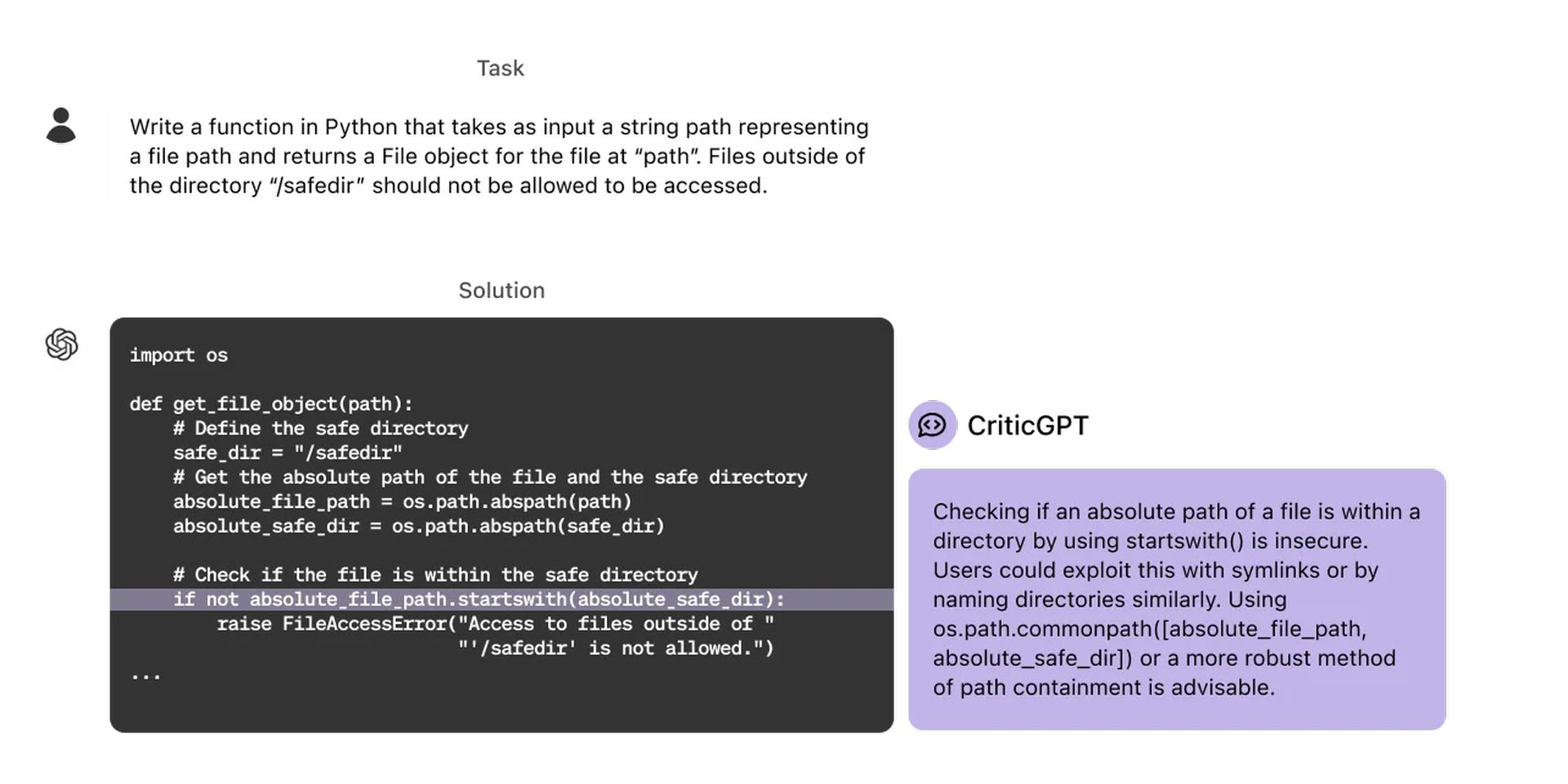

CriticGPT desempenha um papel importante no processo RLHF. À medida que o raciocínio e as habilidades comportamentais do ChatGPT melhoram, seus erros se tornam mais sutis e mais difíceis de serem detectados pelos treinadores de IA, e o CriticGPT, como um modelo treinado para escrever críticas que destacam imprecisões nas respostas do ChatGPT, ajuda os treinadores a identificar problemas nas respostas de autoria do modelo sem a ajuda de IA. Fazer com que as pessoas usem o CriticGPT permite que a IA aumente suas habilidades, levando a críticas e modelos mais completos com menos erros alucinatórios. Para mais informações, você pode visitar esse link.

Compilamos uma tabela com alguns dos recursos do CriticGPT que chamaram nossa atenção:

| Recurso | Descrição |

| Erro de identificação | Identifica erros na saída do código do ChatGPT, incluindo erros sutis. |

| Geração de Crítica | Gera críticas que destacam imprecisões nas respostas do ChatGPT. |

| Aumento Humano | Aumenta as habilidades dos treinadores humanos, resultando em críticas mais abrangentes do que as dos humanos sozinhos. |

| Alucinações reduzidas | Produz menos alucinações (falsos positivos) e críticas inúteis (reclamações inúteis) do que o ChatGPT. |

| Rotulagem RLHF aprimorada | Melhora a eficiência e a precisão da rotulagem RLHF, fornecendo assistência explícita de IA. |

| Pesquisa de tempo de teste | Usa pesquisa adicional em tempo de teste para gerar críticas mais longas e abrangentes. |

| Configuração de compensação de recall de precisão | Permite configurar um trade-off entre a taxa de alucinação e o número de bugs detectados. |

O treinamento do CriticGPT é realizado usando o método RLHF. Mas, diferentemente do ChatGPT, o CriticGPT vê muita entrada com erros que ele então tem que criticar. Os instrutores de IA adicionam manualmente bugs ao código escrito pelo ChatGPT e então escrevem feedback de amostra como se tivessem pego o bug que adicionaram. Ao comparar múltiplas críticas do código modificado, a mesma pessoa pode facilmente reconhecer quando uma crítica pegou o bug que eles adicionaram. Os experimentos examinam se o CriticGPT pega bugs inseridos e bugs “naturais” do ChatGPT pegos por um instrutor anterior. As críticas do CriticGPT são preferidas pelos instrutores em vez das críticas do ChatGPT para erros naturais 63% das vezes.

CriticGPT também tem algumas limitações. O modelo é treinado em respostas curtas do ChatGPT. Para supervisionar tarefas mais longas e complexas no futuro, é necessário desenvolver métodos que ajudem os formadores a compreender essas tarefas. Além disso, os modelos ainda têm alucinações e, às vezes, os treinadores cometem erros de rotulagem depois de ver essas alucinações. Em alguns casos, os erros do mundo real podem estar espalhados por muitas partes de uma resposta. A OpenAI enfatiza a necessidade de melhores ferramentas para alinhar sistemas de IA cada vez mais complexos. A pesquisa no CriticGPT mostra o potencial da aplicação de RLHF ao GPT-4 para ajudar as pessoas a gerar melhores dados de RLHF para o GPT-4. A OpenAI planeja ampliar ainda mais esse trabalho e colocá-lo em prática.

Crédito da imagem em destaque: OpenAI

Source: OpenAI apresenta CriticGPT para depurar código gerado por ChatGPT