Um novo modelo Meta ImageBind AI de código aberto que une muitos fluxos de dados, como texto, áudio, dados visuais, leituras de temperatura e leituras de movimento, foi tornado público pela Meta.

O modelo é atualmente apenas um empreendimento de pesquisa sem consumidor imediato ou aplicações práticas, mas sugere um futuro de geração generativa. sistemas de IA que podem produzir experiências imersivas e multissensoriais. Também demonstra como abertamente meta ainda está compartilhando sua pesquisa de IA em contraste com concorrentes como OpenAI e Googleambos os quais se tornaram mais reclusos.

A ideia central do estudo é a integração de vários tipos de dados em um único índice multidimensional (ou “incorporação espaço,” usar jargão de IA). Embora possa parecer um pouco abstrato neste ponto, a noção fundamental por trás do recente aumento da IA generativa é a mesma.

O que é Meta ImageBind AI?

Por exemplo, durante a fase de treinamento, vários geradores de imagem AI, incluindo DALL–E, Estábulo Difusãoe meio da jornada, contam com esses sistemas. Ao relacionar esses dados com as descrições das fotos, eles procuram padrões nos dados visuais. Isso, portanto, permite que esses sistemas produzam imagens que correspondam às entradas de texto dos usuários. Várias tecnologias de IA também produzem vídeo ou áudio de maneira semelhante.

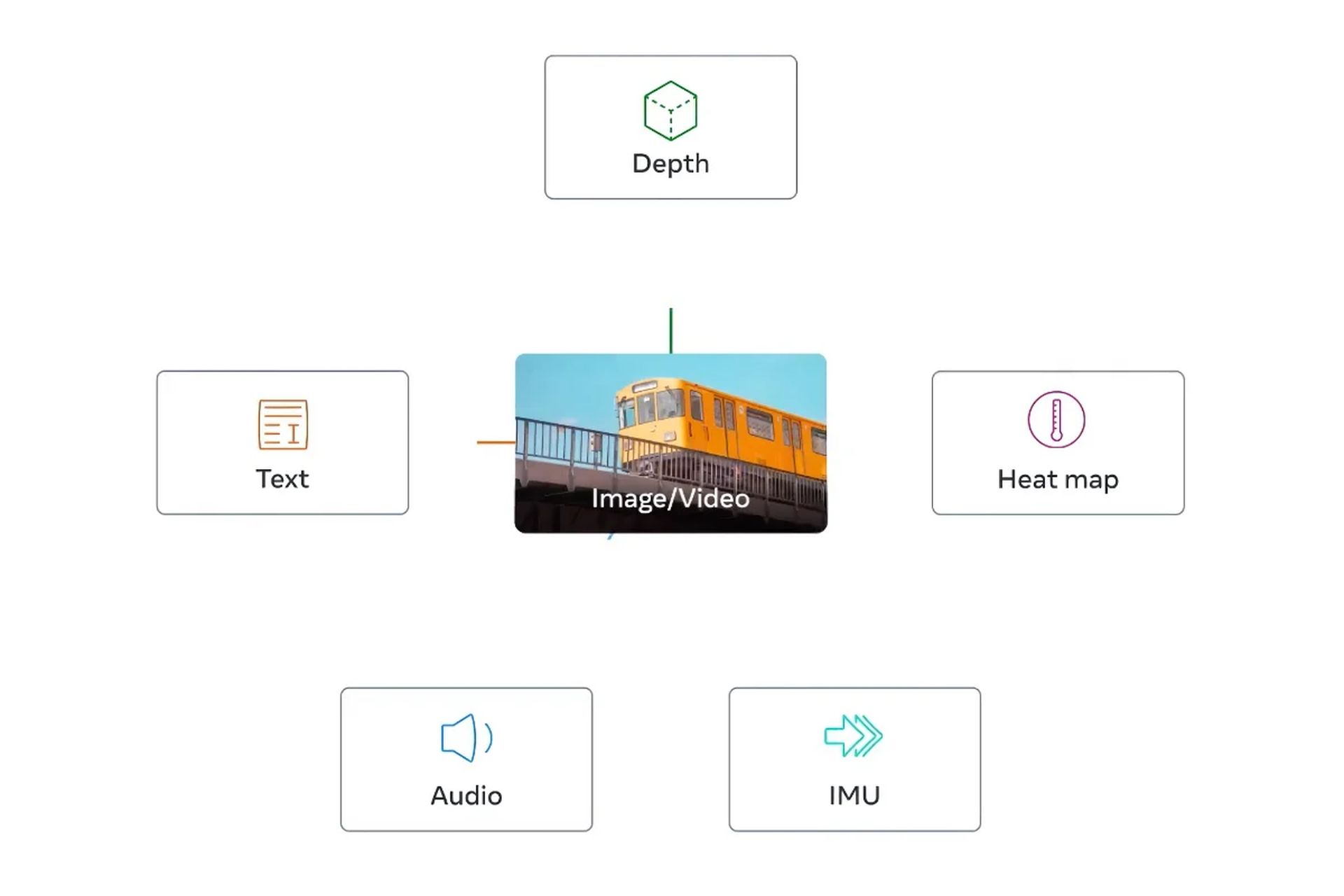

De acordo com Meta ImageBind AI é o primeiro modelo a integrar seis diferentes formulários de dados em um único espaço de incorporação. Visual (na forma de imagem e vídeo), térmico (imagens infravermelhas), texto, áudio, informações de profundidade e – o mais intrigante – medições de movimento produzidas por uma unidade de medição inercial, ou IMU, são as seis categorias de dados incorporadas no modelo.

As IMUs são usadas em telefones e smartwatches para uma variedade de funções, incluindo mudar um telefone do modo paisagem para retrato e identificar várias formas de físico atividade.

A noção é que, como os atuais sistemas de IA fazem com entradas de texto, os futuros sistemas de IA poderão fazer referência cruzada a esses dados. Considere um sistema de realidade virtual futurista, por exemplo, que cria não apenas entrada de áudio e visual, mas também sua ambiente e movimento em um palco real.

Se você pedisse para simular um longo cruzeiro marítimo, ele o colocaria em um navio com o tremor do convés sob seus pés e o vento frio do ar do oceano, além do som das ondas ao longe.

Como funciona o Meta ImageBind AI?

Em uma postagem no blog, Meta ImageBind AI menções que os modelos futuros podem incluir “sinais de toque, fala, cheiro e fMRI cerebral”. A descoberta, de acordo com o comunicado, “traz as máquinas um passo mais perto da capacidade dos humanos de aprender simultaneamente, de forma holística e diretamente de muitas formas diferentes de informação”. O que está bem; qualquer que seja. o quão minuciosos são esses estágios determinará.)

Naturalmente, tudo isso é bastante hipotético, e é provável que os usos imediatos desse tipo de estudo sejam consideravelmente mais restritos. Por exemplo, meta mostrou lançou um modelo de IA no ano passado que cria filmes breves e borrados a partir de descrições de texto. Futuras iterações do sistema podem combinar fluxos de dados adicionais, produzindo áudio para complementar a saída de vídeo, por exemplo, conforme demonstrado por trabalhos como o ImageBind.

No entanto, para aqueles que acompanham o setor, a pesquisa é particularmente intrigante, pois o Meta ImageBind AI está abrindo o código do modelo subjacente, uma tendência que está sendo observada de perto no campo da IA.

Abordagem de código aberto Meta ImageBind AI: por que funciona?

Aqueles que são contra o código aberto, como OpenAIafirmam que a abordagem é ruim para os criadores porque os concorrentes podem duplicar seu trabalho e que pode até ser perigoso, pois pode permitir que atores nefastos explorem modelos de IA de ponta.

Em resposta, os proponentes afirmam que o código aberto permite que terceiros examinem os sistemas em busca de falhas e consertem algumas de suas deficiências. Eles apontam que pode até ter uma vantagem financeira, pois permite efetivamente que as empresas contratem codificadores externos como funcionários não remunerados para aprimorar seu trabalho.

Embora tenha havido desafios, o Meta ImageBind AI permaneceu solidamente no campo de código aberto até agora. (Por exemplo, seu modelo de linguagem mais recente, LLaMAfoi lançado online no início deste ano.) Em muitos aspectos, a falta de sucesso comercial da IA da empresa (ela não tem um chatbot para competir com Bing, Bardoou ChatGPT) tornou essa estratégia possível. Essa tática ainda está sendo usada com ImageBind nesse meio tempo.

Confira os artigos abaixo para se manter atualizado sobre os avanços mais recentes da tecnologia, especialmente aqueles relacionados à IA.

- Conhecer o ChatGPT é a chave para ser contratado: Sim, diz uma startup japonesa

- Visual ChatGPT está aqui para evoluir os geradores de texto para imagem

- Midjourney V5 está aqui para deleitar seus olhos!

Source: O modelo Meta ImageBind AI abre novos caminhos na IA generativa