A Nvidia está revolucionando o mundo da computação de inteligência artificial com o recente lançamento do NVIDIA H200. Esta plataforma de ponta, construída sobre o funil NVIDIA arquitetura, possui a poderosa GPU NVIDIA H200 Tensor Core, equipada com memória avançada projetado para enfrentar cargas substanciais de dados para cargas de trabalho generativas de IA e computação de alto desempenho (HPC).

arquitetura, possui a poderosa GPU NVIDIA H200 Tensor Core, equipada com memória avançada projetado para enfrentar cargas substanciais de dados para cargas de trabalho generativas de IA e computação de alto desempenho (HPC).

Neste artigo, iremos nos aprofundar no lançamento recente e fornecer o máximo de detalhes possível sobre o novo NVIDIA H200.

O poder da NVIDIA H200

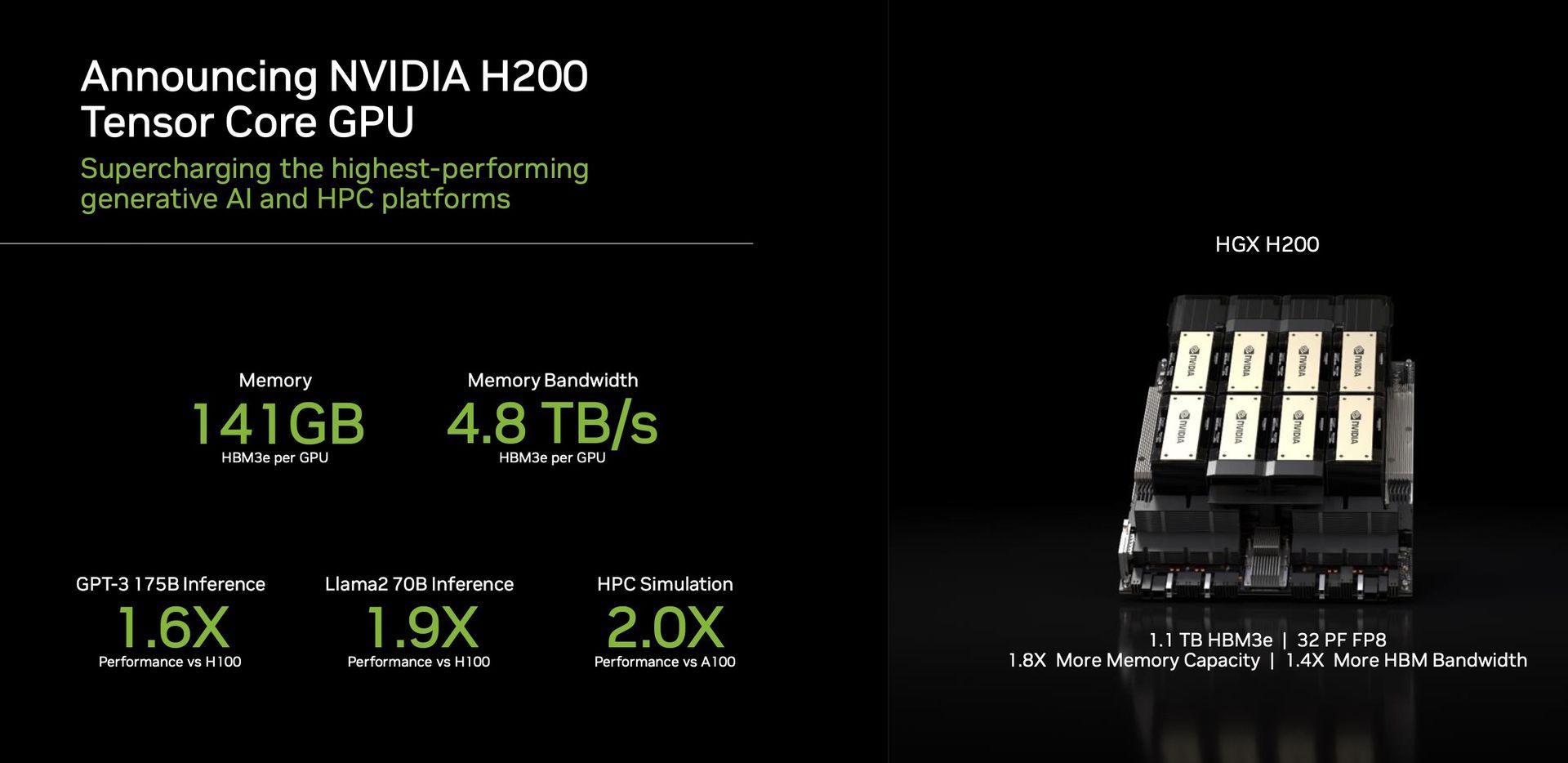

Uma característica de destaque do H200 é sua utilização do HBM3e, a primeira GPU a oferecer memória maior e mais rápida. Este avanço impulsiona a aceleração da IA generativa e de grandes modelos de linguagem, ampliando simultaneamente os limites da computação científica para cargas de trabalho de HPC. Com o HBM3e, o H200 oferece uma impressionante 141 GB de memória em um impressionante 4,8 terabytes por segundo. Isto representa quase o dobro da capacidade e 2,4 vezes mais largura de banda em comparação com seu antecessor, a NVIDIA A100.

Desempenho e aplicações

O H200, alimentado por NVIDIA NV Link e NVSwitch

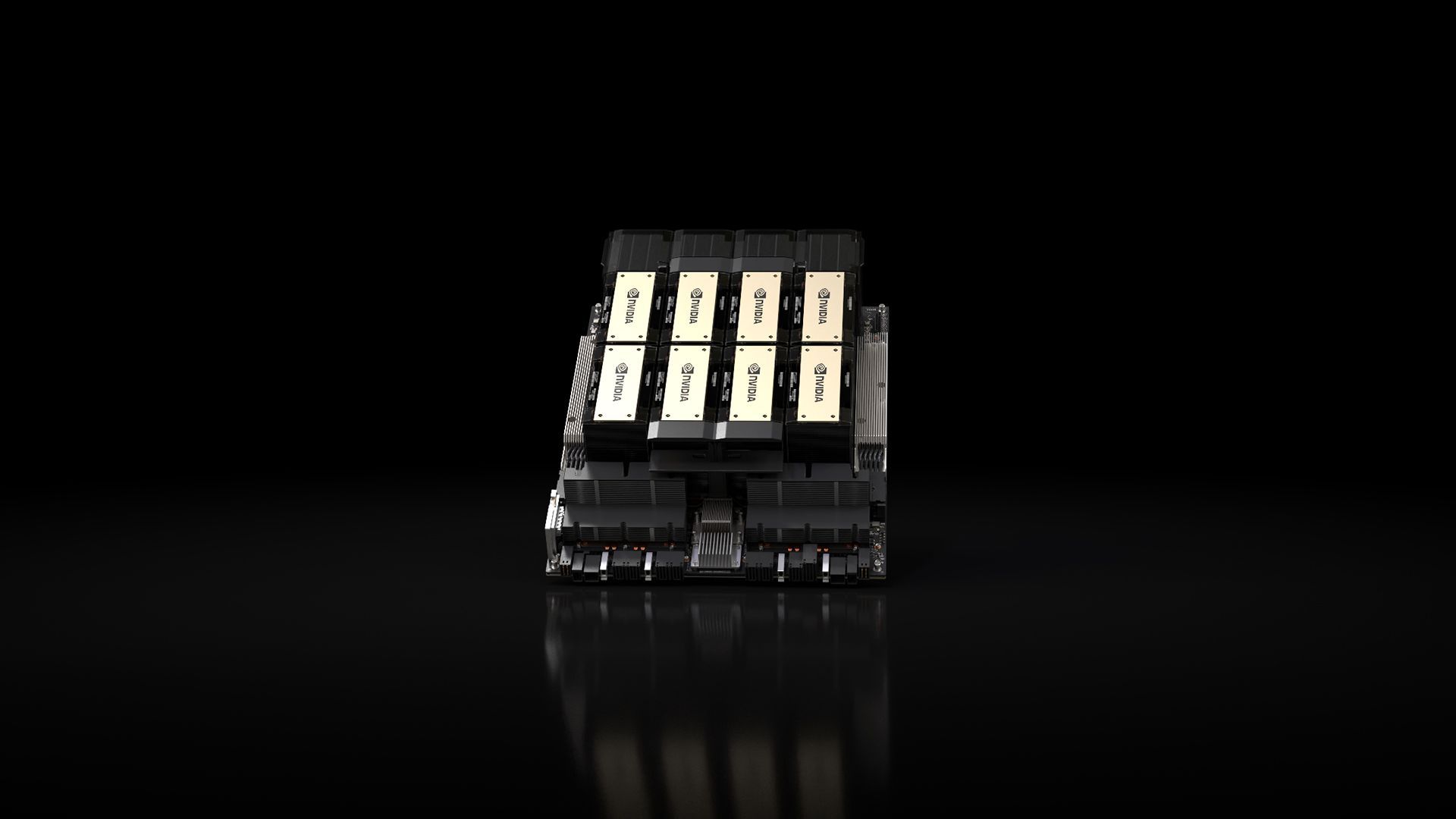

e NVSwitch interconexões de alta velocidade, promessas desempenho incomparável em várias cargas de trabalho de aplicativos. Isso inclui sua habilidade no treinamento LLM (Large Language Model) e inferência para modelos que superam um colossal 175 bilhões de parâmetros. Um HGX H200 de oito vias se destaca por fornecer mais 32 petaflops de profundidade FP8 aprendendo computação e uma memória agregada de alta largura de banda de 1,1 TB, garantindo desempenho máximo em aplicações generativas de IA e HPC.

interconexões de alta velocidade, promessas desempenho incomparável em várias cargas de trabalho de aplicativos. Isso inclui sua habilidade no treinamento LLM (Large Language Model) e inferência para modelos que superam um colossal 175 bilhões de parâmetros. Um HGX H200 de oito vias se destaca por fornecer mais 32 petaflops de profundidade FP8 aprendendo computação e uma memória agregada de alta largura de banda de 1,1 TB, garantindo desempenho máximo em aplicações generativas de IA e HPC.

As GPUs da Nvidia se tornaram fundamental no domínio dos modelos generativos de IA, desempenhando um papel crucial no seu desenvolvimento e implantação. Projetadas para lidar com cálculos paralelos massivos necessários para treinar e executar esses modelos, as GPUs da Nvidia se destacam em tarefas como geração de imagem e linguagem natural em processamento. A arquitetura de processamento paralelo permite que essas GPUs executem numerosos cálculos simultaneamente, resultando em uma aceleração substancial dos processos de modelos de IA generativos.

O H200 é uma prova do compromisso da Nvidia com inovação perpétua e saltos de desempenho. Com base no sucesso da arquitetura Hopper, melhorias contínuas de software, incluindo o recente lançamento de bibliotecas de código aberto como NVIDIA TensorRT -LLM, continuar a elevar o desempenho da plataforma. A introdução do NVIDIA H200 promete novos avanços, com expectativas de quase dobrando a velocidade de inferência em modelos como o Llama 2, um LLM de 70 bilhões de parâmetros, em comparação com seu antecessor, o H100.

-LLM, continuar a elevar o desempenho da plataforma. A introdução do NVIDIA H200 promete novos avanços, com expectativas de quase dobrando a velocidade de inferência em modelos como o Llama 2, um LLM de 70 bilhões de parâmetros, em comparação com seu antecessor, o H100.

Versatilidade e disponibilidade

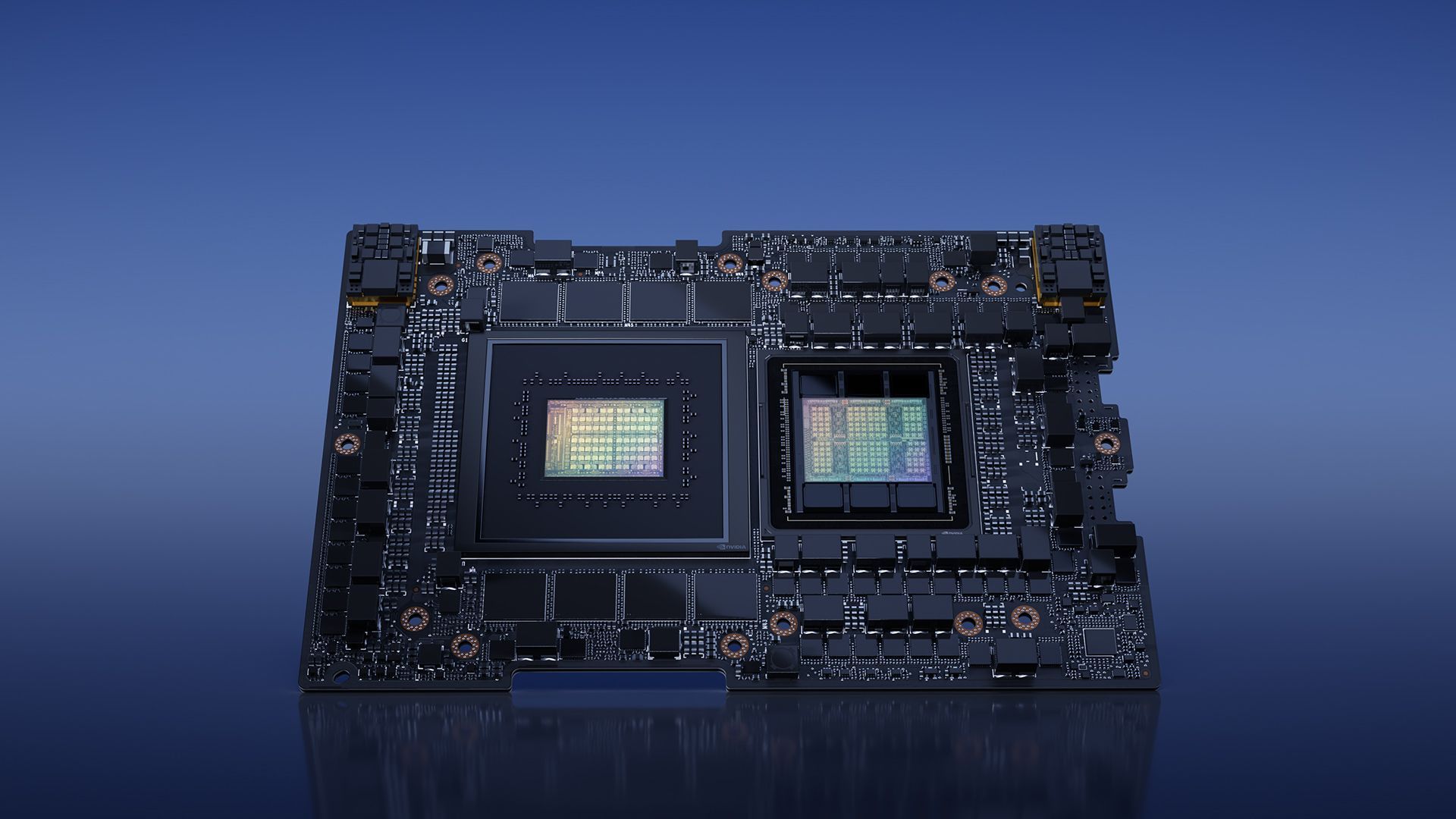

Nvidia garante versatilidade com o H200, oferecendo-o em vários formatos, como placas para servidores NVIDIA HGX H200 com configurações de quatro e oito vias. Essas configurações são compatíveis com hardware e software dos sistemas HGX H100. Além disso, NVIDIA H200 está disponível em o NVIDIA GH200 Grace Hopper Superchip com HBM3e, atendendo a diferentes configurações de data center, incluindo ambientes locais, em nuvem, em nuvem híbrida e de borda. O ecossistema global de fabricantes de servidores parceiros pode atualizar perfeitamente seus sistemas existentes com o H200, garantindo ampla acessibilidade.

Superchip com HBM3e, atendendo a diferentes configurações de data center, incluindo ambientes locais, em nuvem, em nuvem híbrida e de borda. O ecossistema global de fabricantes de servidores parceiros pode atualizar perfeitamente seus sistemas existentes com o H200, garantindo ampla acessibilidade.

Entusiastas e especialistas do setor aguardam ansiosamente o lançamento dos sistemas HGX H200, que deverão chegar ao mercado em o segundo trimestre de 2024. Atores globais proeminentes, como Amazon Web Services, Google Nuvem, Microsoft Azure, e Infraestrutura em Nuvem Oracle estão entre a primeira onda de provedores de serviços em nuvem pronta para implantar instâncias baseadas em H200 no próximo ano.

arquitetura (Crédito da imagem)

arquitetura (Crédito da imagem)Concluindo, o NVIDIA H200, com seus recursos e capacidades de desempenho inovadores, está configurado para redefinir o cenário da computação de IA. Quando estiver disponível no segundo trimestre de 2024, o H200 está preparado para capacitar desenvolvedores e empresas em todo o mundo, acelerando o desenvolvimento e implantação de aplicações de IA da fala à inferência em hiperescala.

Enquanto isso, se você estiver interessado na empresa líder em tecnologia, não deixe de conferir também nosso artigo sobre como a Nvidia e a AMD estão trabalhando em um “chip baseado em braço”.

Crédito da imagem em destaque: NVIDIA

Source: NVIDIA H200 é apresentado com grande expectativa na esfera de IA