A Microsoft tem lançado um novo desenvolvimento interessante no campo de modelos de linguagem: o LLM de 1 bit. Este avanço, inspirado em projetos de pesquisa como BitNet, marca uma mudança notável na forma como os modelos de linguagem são construídos e otimizados. No centro desta inovação está um método surpreendentemente eficiente de representar parâmetros de modelo – ou pesos –usando apenas 1,58 bits, em oposição ao tradicional ponto flutuante de 16 bits (FP16) abordagem predominante em modelos anteriores.

O primeiro LLM de 1 bit do tipo

Apelidado BitNet LLM b1.58esta abordagem pioneira limita os valores potenciais de cada peso a apenas três opções: -1, 0 ou +1. Esta redução drástica no número de bits necessários por parâmetro é o que estabelece as bases para esta tecnologia inovadora. Surpreendentemente, apesar do baixo consumo de bits, o BitNet b1.58 consegue fornecer métricas de desempenho comparáveis às dos modelos tradicionais. Isso inclui áreas como perplexidade e desempenho da tarefa final, tudo isso usando conjuntos de dados do mesmo tamanho e treinamento.

O que são LLMs de 1 bit?

O cenário generativo da IA está evoluindo dia a dia, e o mais recente avanço nesta área dinâmica é o advento dos modelos de aprendizagem de línguas de 1 bit. Pode parecer surpreendente, mas este desenvolvimento tem o potencial de transformar a arena da IA, abordando alguns dos obstáculos mais significativos enfrentados pelos LLMs hoje:ou seja, seu tamanho gigantesco.

Normalmente, os pesos de um modelo de aprendizado de máquina, seja um LLM ou algo tão simples como a regressão logística, são armazenados usando Pontos flutuantes de 32 ou 16 bits. Esta abordagem padrão é uma faca de dois gumes; ao mesmo tempo que permite alta precisão nos cálculos dos modelos, também resulta no imenso tamanho desses modelos.

Esse inchaço é exatamente o motivo pelo qual a implantação de campeões de peso como o GPT em sistemas locais ou em ambientes de produção se torna um pesadelo logístico. Seu número astronômico de pesos, exigido pela precisão desses pontos flutuantes, aumenta seu tamanho a proporções incontroláveis.

Em total contraste com os modelos tradicionais, LLMs de 1 bit utilizam apenas um bit – 0 ou 1 – para representar parâmetros de peso. Este ajuste aparentemente menor tem implicações importantes: reduz drasticamente o tamanho geral dos modelos, potencialmente por uma vasta margem.

Essa redução no tamanho abre caminho para a implantação de LLMs em dispositivos muito menorestornando os aplicativos avançados de IA mais acessível e viável em uma ampla gama de plataformas.

Voltar para BitNet LLM b1.58

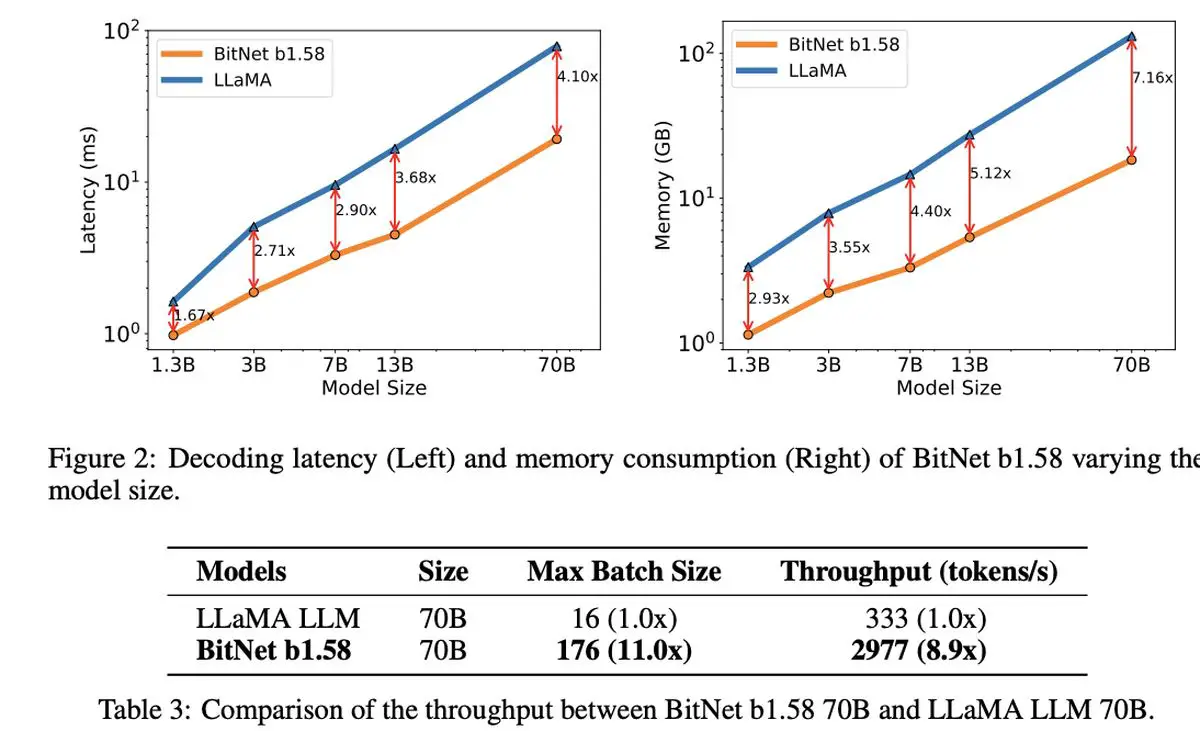

O que é verdadeiramente notável no LLM de 1,58 bits é a sua custo-benefício. O modelo brilha em termos de latência reduzida, menor uso de memória, maior rendimento e menor consumo de energia, apresentando uma opção sustentável no mundo computacionalmente intensivo da IA.

LLM de 1 bit da Microsoft não se destaca apenas pela eficiência. Representa uma nova perspectiva sobre o dimensionamento e treinamento de modelos linguísticos, equilibrando desempenho de alto nível com viabilidade econômica. Ele sugere o surgimento de novos paradigmas de computação e a possibilidade de criação de hardware especializado, feito sob medida para executar esses modelos mais enxutos e eficientes.

A discussão em torno do BitNet LLM b1.58 também abre possibilidades intrigantes para gerenciar sequências longas de forma mais eficaz em LLMssugerindo áreas potenciais para pesquisas futuras em técnicas de compressão sem perdas para aumentar ainda mais a eficiência.

À sombra desta inovação notável, a Microsoft também tem feito barulho com o seu mais recente modelo de linguagem pequena, Phi-2. Esta potência de 2,7 mil milhões de parâmetros demonstrou capacidades excepcionais de compreensão e raciocínio, mais uma prova do compromisso contínuo da Microsoft em ultrapassar os limites da tecnologia de IA. A introdução do LLM de 1 bit, juntamente com o sucesso do Phi-2, destacaria uma era emocionante de inovação e eficiência no desenvolvimento de modelos de linguagem.

Crédito da imagem em destaque: Drew Beamer/Unsplash

Source: Microsoft apresenta seu LLM de 1 bit