Os modelos de linguagem têm revolucionou vários campos com seus recursos avançados, deixando muitas pessoas com dúvidas sobre como usar o Google MusicLM e os modelos GPT da OpenAI, incluindo ChatGPT e Códice, desempenharam um papel significativo nesta ruptura. Esses modelos têm a capacidade de gerar texto e código com eficiência com base em um determinado prompt. Treinado em vastos conjuntos de dadoseles podem ser aplicados a inúmeras tarefas de processamento de linguagem natural (PLN), como análise de sentimentos, sistemas chatbot, resumo, tradução automática, e classificação de documentos.

Embora esses modelos tenham suas limitações, eles oferecem um vislumbre do potencial dos modelos de linguagem para entender idiomas e desenvolver aplicativos que podem melhorar a vida humana. Embora existam preocupações em relação seu potencial para substituir os humanos em vários domínios, a ideia subjacente é aumentar a produtividade e fornecer novas formas de explorar e compreender a linguagem como um todo.

Dado o papel fundamental que a linguagem desempenha na civilização humana, torna-se imperativo construir modelos de linguagem que possam decodificar descrições textuais e realizar tarefas como gerar texto, imagens, áudio e até música. Neste artigo, vamos nos concentrar principalmente em modelos de linguagem musicalque são semelhantes a modelos como ChatGPT e Dall-E, mas em vez de gerar texto ou imagens, eles são projetados para criar música.

A música é uma forma de arte complexa e dinâmica. Envolve a orquestração de múltiplos instrumentos musicais que se harmonizam para criar uma experiência contextual. De notas e acordes individuais a elementos de fala como fonemas e sílabas, a música abrange uma ampla gama de componentes. Em desenvolvimento um modelo matemático capaz de extrair informações de um conjunto de dados tão diversificado é uma tarefa formidável. No entanto, uma vez estabelecido esse modelo, ele pode gerar um áudio realista semelhante ao que os humanos podem produzir.

Com tudo isso em mente, vamos nos aprofundar no conceito central dos modelos de linguagem musical e explorar como eles possibilitam a geração de música. Enquanto isso, se você estiver interessado em aumentar o nível do seu jogo de música, também pode querer verificar como usar o Discord Soundboard e adicionar novos sons a ele.

Entendendo os modelos de linguagem musical e como usar o Google MusicLM

O MusicLM utiliza várias técnicas de aprendizado de máquina, como aprendizado profundo e processamento de linguagem natural, para analisar dados e descobrir representações ocultas que facilitam a geração de música. Esses modelos utilizam conjuntos de dados específicos de música para extrair informações, identificar padrões e aprender um amplo espectro de estilos e gêneros musicais.

MusicLM tem potencial para automatizar uma série de tarefas, incluindo escrevendo partituras analisando a música existente, recomendar novas progressões de acordesou mesmo gerando novos sons. Em última análise, pode introduzir novas formas de música expressão e criatividade, servindo como uma ferramenta valiosa para aprimorar as habilidades dos músicos e facilitar a educação musical.

Apresentando o Google MusicLM

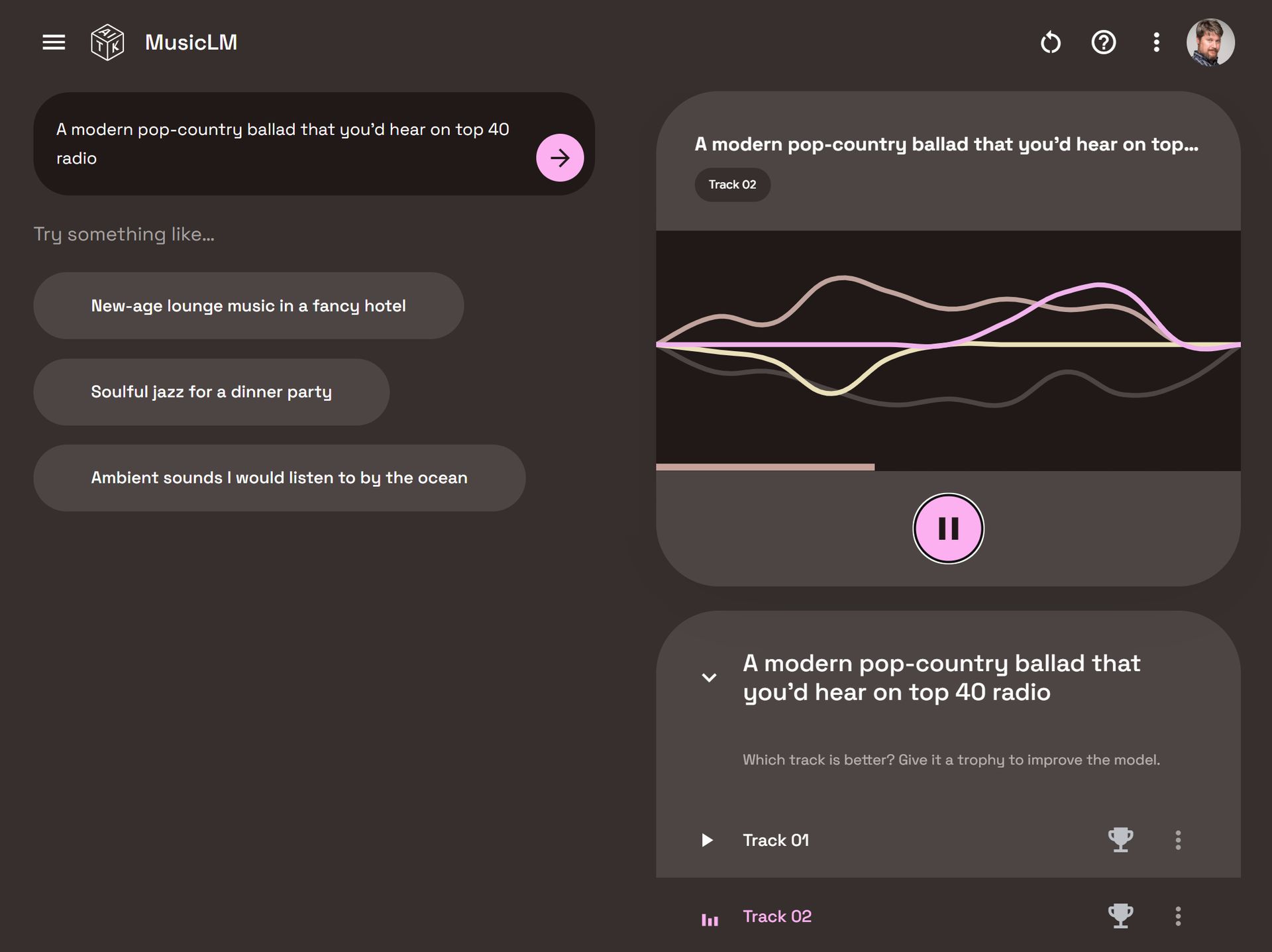

O Google MusicLM é um modelo de linguagem dedicado projetado especificamente para gerar música com base em descrições de texto. Por exemplo, ao fornecer um prompt como “uma melodia calmante de guitarra em um riff de compasso 6/8”, o modelo pode produzir a música correspondente.

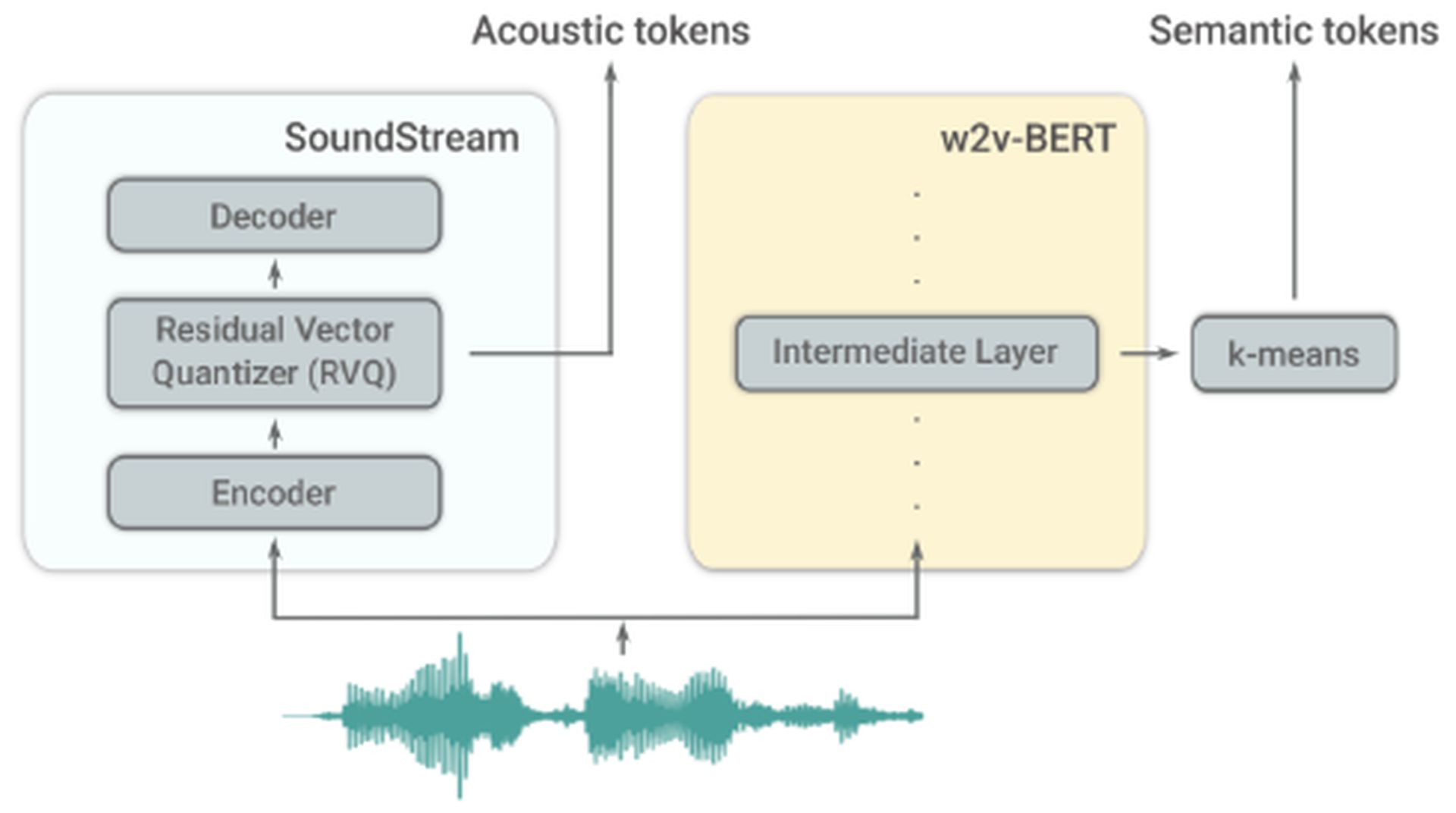

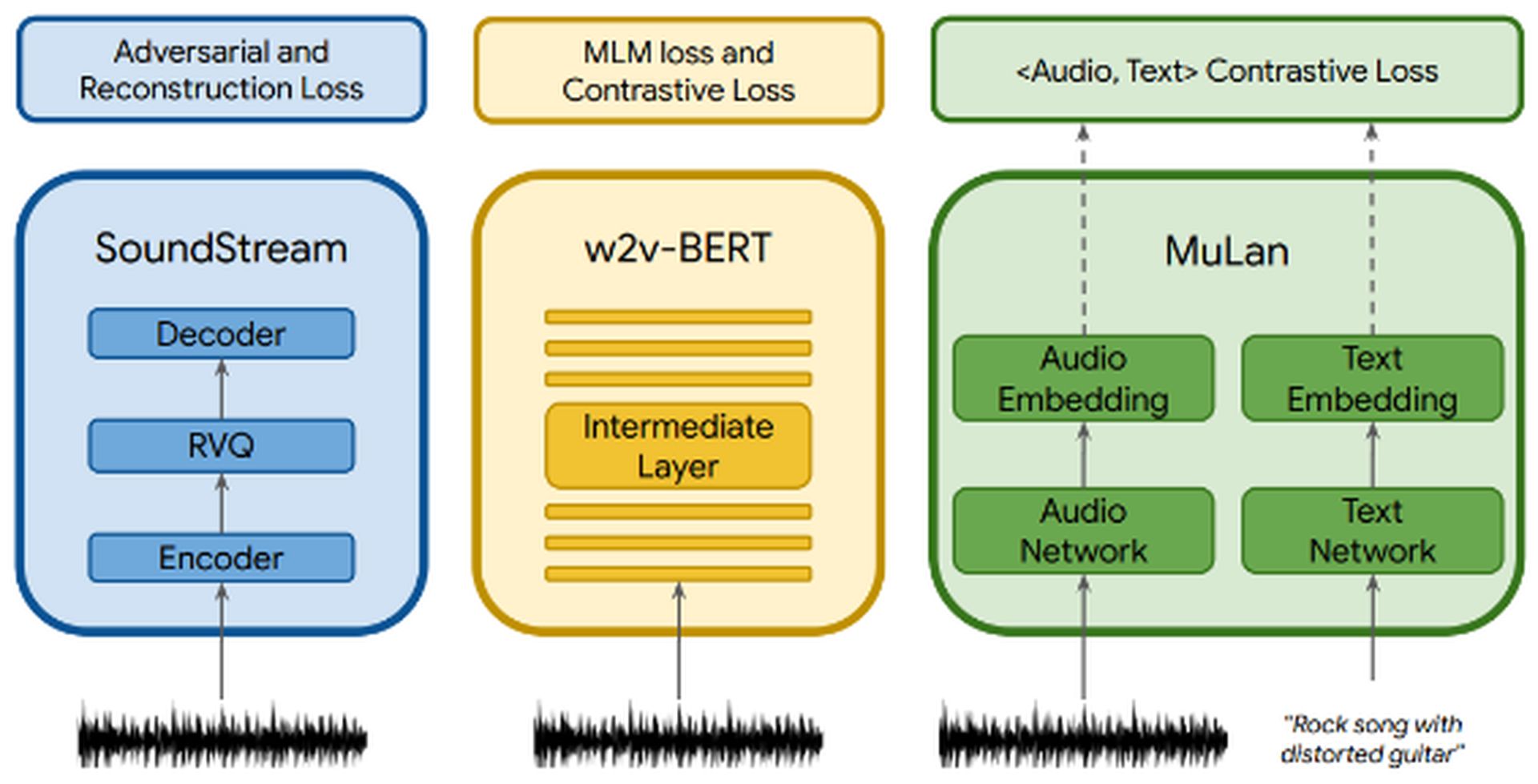

O MusicLM se baseia AudioLM, outro modelo de linguagem desenvolvido pelo Google. AudioLM se concentra em gerar alta qualidade e inteligível continuações de fala e música de piano. Ele consegue isso convertendo o áudio de entrada em uma série de tokens discretos e gerando sequências de áudio com consistência de longo prazo. AudioLM emprega dois tokenizadores: o tokenizer SoundStream, que produz tokens acústicos, e o tokenizador w2v-BERT, que gera tokens semânticos. Esses tokenizadores desempenham um papel crucial na extração de informações.

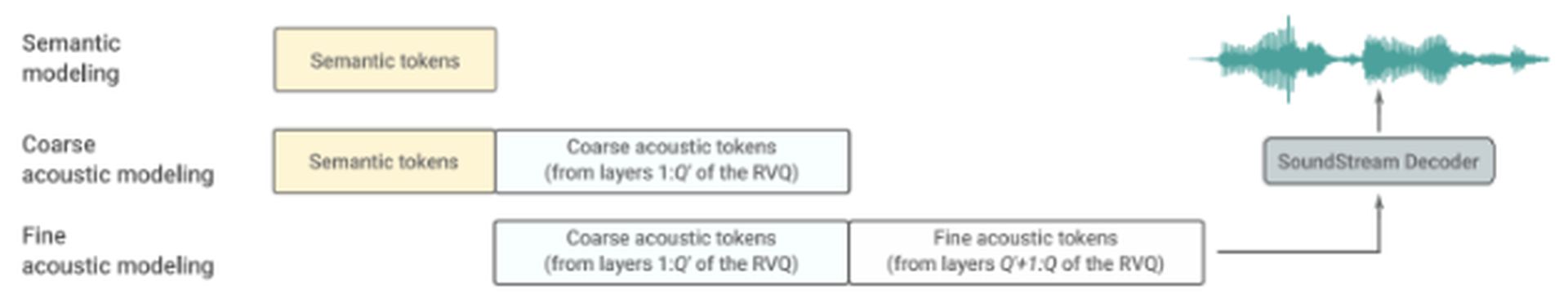

O AudioLM consiste em três estágios hierárquicos:

- Modelagem semântica: Este estágio se concentra em capturar a coerência estrutural de longo prazo. Ele extrai a estrutura de alto nível do sinal de entrada.

- Modelagem acústica grosseira: Aqui, o modelo produz tokens acústicos, que são então concatenados ou condicionados em tokens semânticos.

- Modelagem acústica fina: O áudio final recebe mais profundidade neste estágio, que envolve o processamento de tokens acústicos grosseiros com tokens acústicos finos. O decodificador SoundStream utiliza esses tokens acústicos para recriar uma forma de onda.

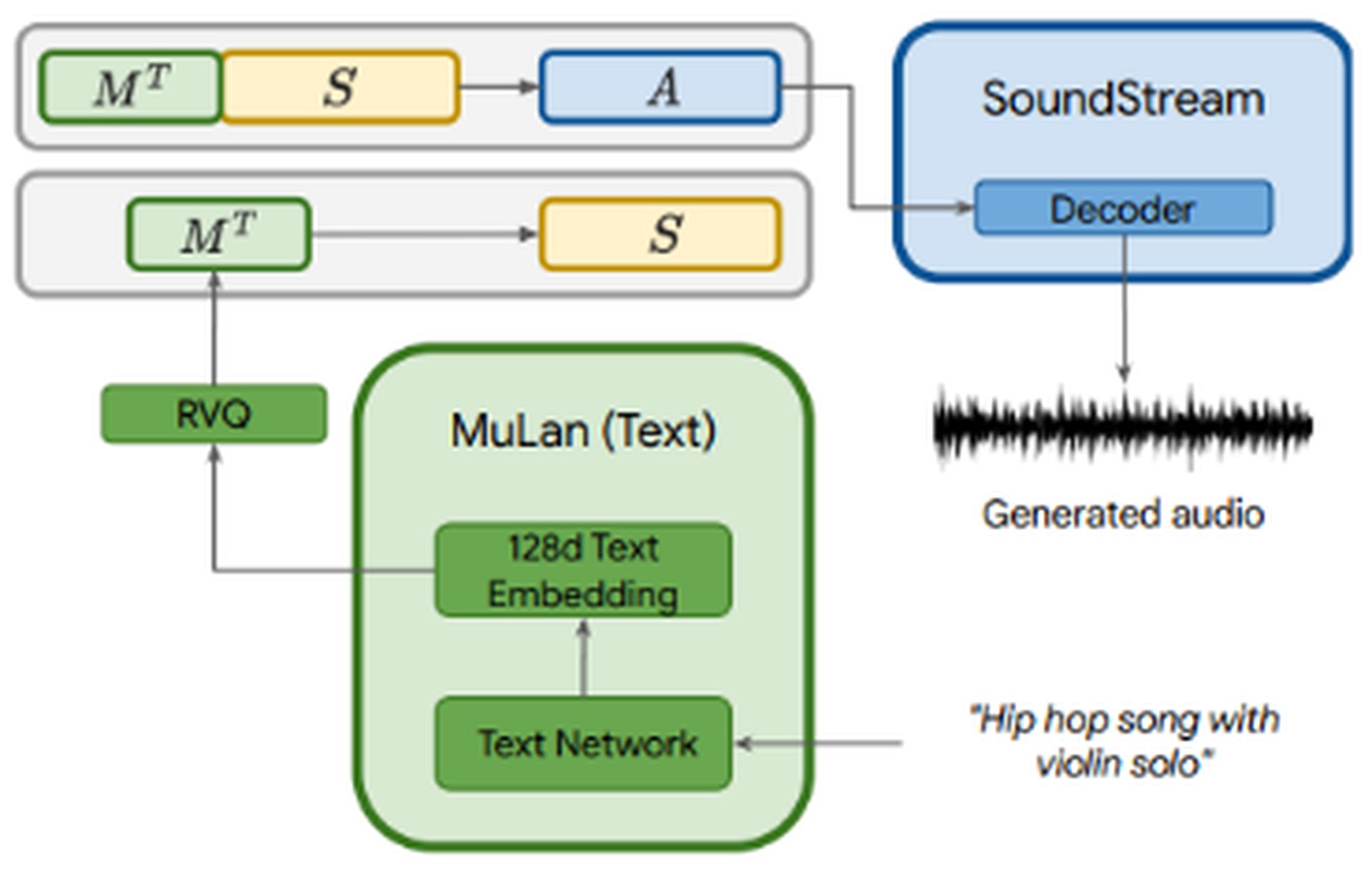

O MusicLM aproveita os AudioLMs modelagem autorregressiva multiestágio como seu componente gerador, ao mesmo tempo em que incorpora condicionamento de texto. O arquivo de áudio é passado por três componentes: SoundStream, w2v-BERT, e MuLan. SoundStream e w2v-BERT processam e tokenizam o sinal de áudio de entrada, enquanto MuLan representa um modelo de incorporação conjunta para música e texto. MuLan consiste em duas torres de incorporaçãoum para cada modalidade (texto e áudio).

Enquanto o áudio é alimentado em todos os três componentes, o a descrição do texto é alimentada apenas no MuLan. As incorporações MuLan são quantizadas para fornecer uma representação padronizada com base em tokens discretos para o sinal de condicionamento e o áudio. A saída do MuLan é então alimentada no estágio de modelagem semântica, onde o modelo aprende o mapeamento de tokens de áudio para tokens semânticos. O processo subsequente se assemelha ao do AudioLM.

O MusicLM, baseado no AudioLM e no MuLan, oferece três vantagens principais:

- Geração musical baseada em descrições de texto.

- Incorporação de melodias de entrada para estender a funcionalidade. Por exemplo, ao fornecer uma melodia sussurrante e instruir o MusicLM a convertê-la em um riff de guitarra, o modelo pode gerar a saída desejada.

- Geração de sequências longas para qualquer instrumento musical.

conjunto de dados

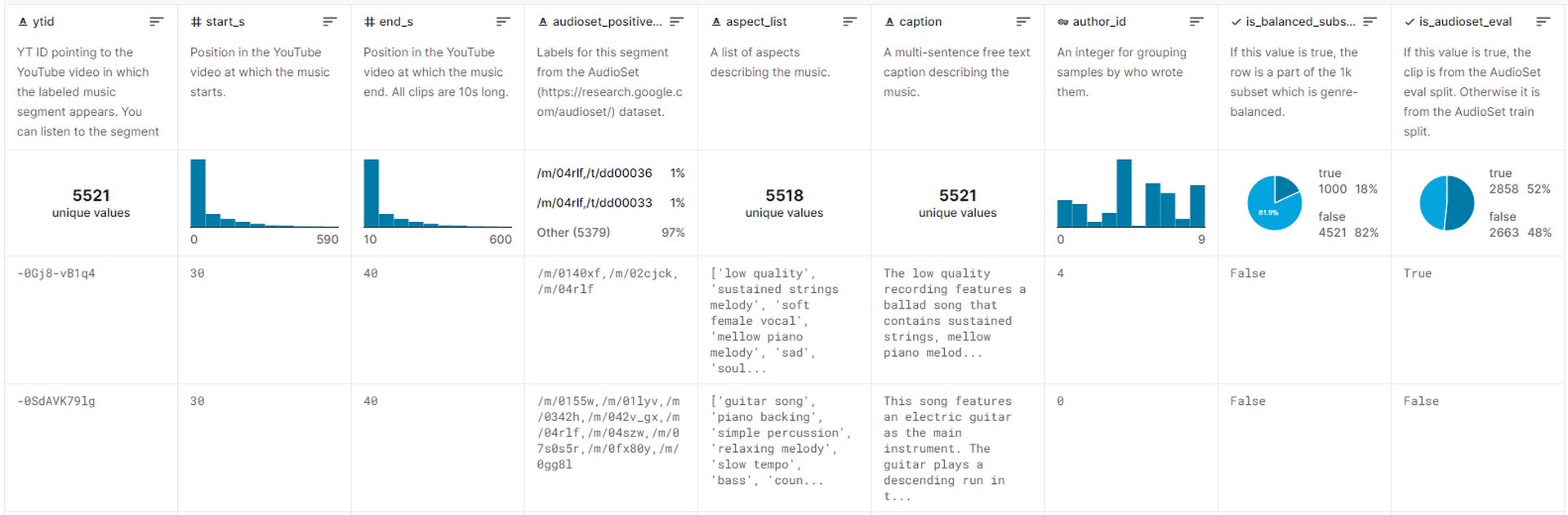

O conjunto de dados usado para treinar MusicLM compreende aproximadamente 5,5 mil pares música-texto. Este conjunto de dados inclui mais de 200.000 horas de músicaacompanhado por descrições de texto rico fornecidos por especialistas humanos. O Google lançou este conjunto de dados no Kaggle, chamado MusicCapse atualmente pode ser acessado pelo público.

Gerando música com o MusicLM

Infelizmente, Atualmente, o Google não tem planos de distribuir modelos relacionados ao MusicLM, citando a necessidade de trabalho adicional. No entanto, o white paper divulgado pelo Google fornece vários exemplos demonstrando como a música pode ser gerada usando descrições de texto.

Aqui estão várias abordagens para gerar música com o MusicLM:

- Legendas ricas: Providenciando descrições detalhadas como “A trilha sonora principal de um jogo de arcade. É rápido e otimista, com um riff cativante de guitarra elétrica. A música é repetitiva e fácil de lembrar, mas com sons inesperados como batidas de pratos ou tambores ruidosos,” o MusicLM pode criar música que se alinha com contextos e requisitos específicos.

- Geração longa: Essa abordagem envolve a geração de áudio contínuo e de alta fidelidade por períodos prolongados, como 5 minutos. Usando prompts como “Heavy metal” ou “reggae calmante”, os usuários podem obter música dentro do gênero e estilo desejados.

- Modo história: Um recurso notável do MusicLM é a capacidade de gerar uma sequência de música com base em uma série de prompts de texto. Por exemplo, especificando diferentes intervalos de tempo e atividades correspondentes como “tempo para meditar (0:00-0:15)“, “hora de acordar (0:15-0:30)“, e assim por diante, os usuários podem orquestrar uma jornada musical.

- Condicionamento de texto e melodia: Essa abordagem permite que os usuários produzam música que adere a uma melodia fornecida, como uma sequência de zumbidos ou assobios respeitando o prompt de texto fornecido. Essencialmente, ele converte uma sequência de áudio na saída desejada.

- Condicionamento de legenda de pintura: MusicLM pode gerar música com base em descrições de pintura. Por exemplo, fornecendo uma descrição da famosa obra de arte de Salvador Dali “A Persistência da Memória“, a modelo pode criar músicas inspiradas nos conceitos e imagens da pintura.

- Lugares: Descrições de lugares ou ambientes específicos podem servir como sugestões para gerar música. Por exemplo, usando uma descrição como “um tempo ensolarado e tranquilo na praia“, MusicLM pode gerar música que encapsula a essência daquele cenário.

Exemplos adicionais incluem a geração de áudio de 10s a partir do texto, considerando os níveis de experiência do músico, épocas e até solos de acordeão. O MusicLM oferece um conjunto versátil de recursos para gerar música em vários domínios e cenários.

As impressionantes capacidades do MusicLM em gerar música de alta fidelidade mostrar o notável potencial da criatividade humana, em vez de depender apenas de algoritmos de IA. No entanto, esse avanço também aumenta preocupações éticas e pode enfrentar resistência da comunidade musicalsemelhante a modelos de geração de imagens como Dalle e ChatGPT.

Os pesquisadores do Google reconhecem as questões éticas associado a um sistema como MusicLM, incluindo o potencial para incorporando conteúdo protegido por direitos autorais de dados de treinamento nas músicas geradas. Durante experimentos, eles descobriram que 1% da música gerada pelo sistema replicou diretamente as músicas de seus dados de treinamento. Essa porcentagem foi considerada muito alto para lançar o MusicLM em sua forma atual.

Embora seja improvável que o MusicLM se torne um aplicativo publicamente disponível em um futuro próximo, podemos antecipar o surgimento de modelos de música de código aberto que podem passar por engenharia reversa por desenvolvedores independentes. o futuro reserva possibilidades emocionantes para alavancar modelos de linguagem para aprimorar a criatividade e a expressão musical, garantindo o uso responsável e ético dessas tecnologias.

Source: Como usar o Google MusicLM: um guia completo